Lightweight Multisource Object Detection Based on Group Feature Extraction

-

摘要:

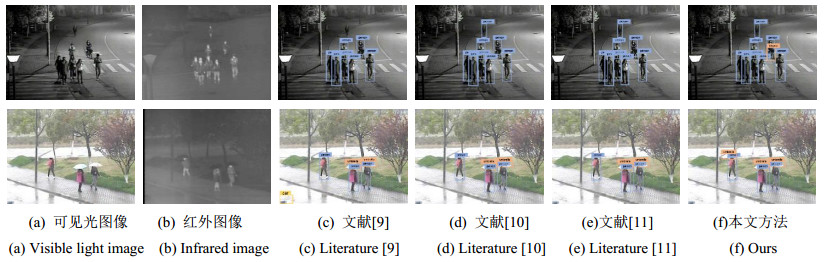

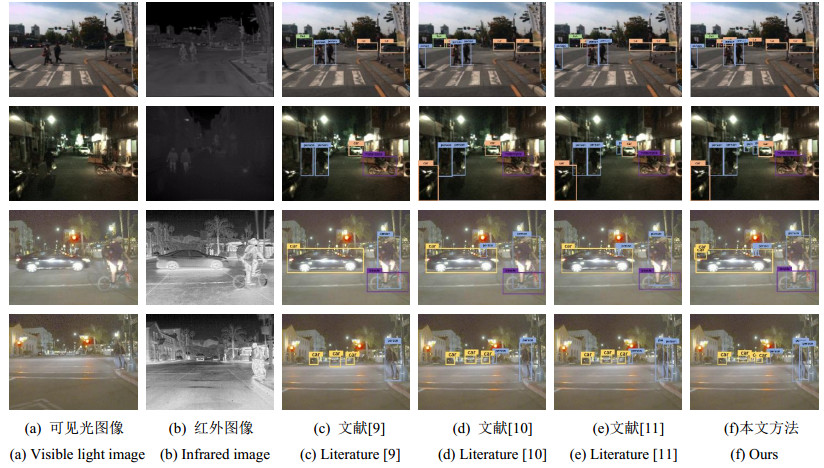

为兼顾多源目标检测网络的精度与效率,将分组卷积作用于目标多模态特征中,并配合注意力多尺度结构以及改进的目标框筛选策略,设计了一种轻量级的红外与可见光目标检测模型。模型先以多种特征降维策略对输入图像进行采样,降低噪声及冗余信息的影响;其次,根据特征通道所属模态进行分组,并利用深度可分离卷积分别对红外特征、可见光特征以及融合特征进行提取,提升多源特征提取结构的多样性以及高效性;然后,针对各维度多模态特征,引入改进的注意力机制来增强关键特征,再结合邻域多尺度融合结构保障网络的尺度不变性;最后,利用优化后的非极大值抑制算法来综合各尺度目标预测结果,精确检测出各个目标。通过在KAIST、FLIR、RGBT公开数据集上的测试结果表明,所提模型有效提升了目标检测性能,并且相对于同类型多源目标检测方法,该模型也体现出较高的鲁棒性和泛化性,可以更好地实现目标检测。

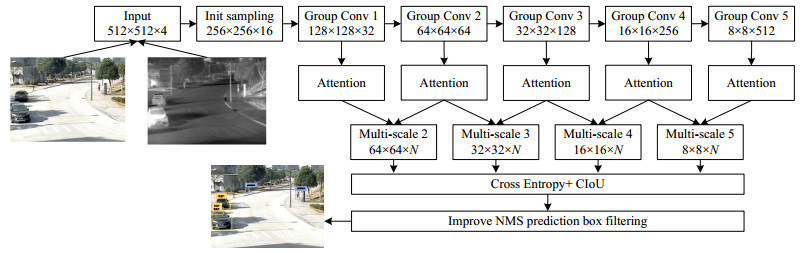

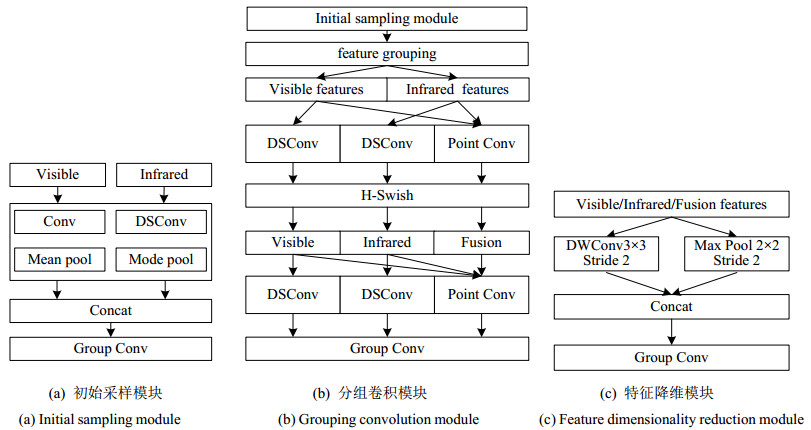

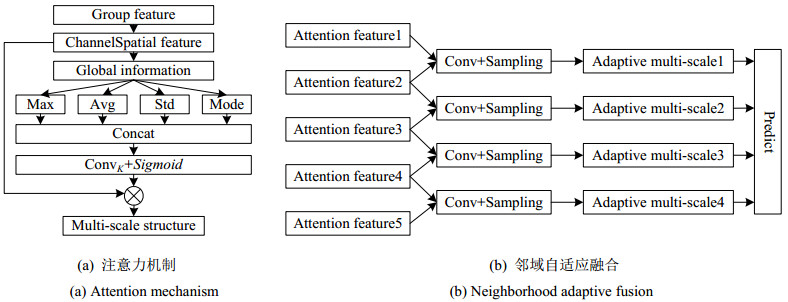

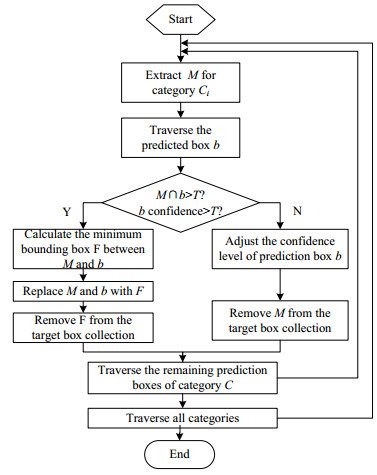

Abstract:To balance the accuracy and efficiency of multisource object detection networks, a lightweight infrared and visible light object detection model with a multiscale attention structure and an improved object-box filtering strategy was designed by applying group convolution to multimodal object features. First, multiple feature dimensionality reduction strategies were adopted to sample the input image and reduce the impact of noise and redundant information. Subsequently, feature grouping was performed based on the mode of the feature channel, and deep separable convolution was used to extract infrared, visible, and fused features, to enhance the diversity and efficiency of extracted multisource feature structures. Then, an improved attention mechanism was utilized to enhance key multimodal features in various dimensions, combining them with a neighborhood multiscale fusion structure to ensure scale invariance of the network. Finally, the optimized non-maximum suppression algorithm was used to synthesize the prediction results of objects at various scales for accurate detection of each object. Experimental results based on the KAIST, FLIR, and RGBT public thermal datasets show that the proposed model effectively improves object detection performance compared with the same type of multisource object detection methods.

-

0. 引言

航空发动机是航空飞行器中的核心部分,它的机械结构异常复杂,其可以产生足够动力支持航空飞行器的正常运行。航空发动机的正常运转将直接决定航空飞行器的可靠性和安全性,影响了航空飞行器的飞行安全[1-2]。航空发动机叶片正常工作对整个航空飞行器的飞行安全非常关键,在生产和服役过程中一直都需要对其进行检测和监测。作为航空发动机的重要组成部分,航空发动机长期在高温、高压、缺氧的恶劣环境下,在高频率振动、高温、高压的共同作用下,发动机叶片的结构强度和振动问题比较明显,容易导致叶片出现裂纹甚至是断裂情况。叶片裂纹根据断裂力学理论,处于扩展区域的裂纹将呈现指数形式的扩展,微小裂纹的危害将很快显现出来[3]。因此针对航空发动机的叶片检测显得尤为重要,不仅可以对叶片裂纹的状态进行判断,也可以对航空发动机的安全进行评估[4]。

目前对航空发动机叶片裂纹的检测主要为两大类:破坏性检测方法和非破坏性检测方法。破坏性检测方法是指通过破坏叶片样品进行微晶分析; 非破坏性方法是指采用无损检测方式对叶片样品进行检测,不破坏叶片表面结构,采用常见的物理或者化学方法对叶片进行无损检测,敲击法、磁粉检测、孔探仪、渗透检测、超声检测等[5-9]。敲击法对发动机叶片进行敲击,根据声音判断叶片是否存在裂纹,但该方式需要丰富的经验,并且容易误判或者漏检; 磁粉检测根据试件表面磁力线局部异常产生磁场吸附磁粉,在特殊光照下形成磁痕从而检测出缺陷,但该检测方式需要消磁和清理检测区域,响应速度慢、检测效率低; 渗透检测主要采用荧光等渗透剂喷洒在试件表面,通过紫外灯检测出样品表面裂纹,渗透检测过程中不仅需要喷洒荧光剂,还需要同时施加显影剂; 磁粉检测过程中需要消磁和清理被测区域,响应速度慢、耗时长、不适合现场批量检测[5-7]。超声检测利用超声波在试件内部传播,遇到声阻抗不同的界面发生反射、折射,对接收到的反射波进行分析来检测缺陷,但对于叶片类异形曲面结构,由于超声波在试件内部传播异常复杂,难以有效把握超声波传播规律,因而难于应用到实际检测中[10]。

超声红外热成像技术作为一种新型的红外检测技术,结合了超声激励和红外热成像技术,采用主动热激励方式对试件内部进行热激励[11-12],; 超声激励为体加热方式,相对于脉冲红外热成像技术的面加热方式,体加热方式可以多维度区域加热,同时超声激励属于选择性激励,仅在缺陷区域产生温升,非缺陷区域不产生温升,能更有效避免周围热波信号的干扰,从而超声激励方式能更有效地检测试件内微小裂纹[13-14]。目前在西方先进工业国家已经成功地应用在航天航空领域的关键金属部件的裂纹缺陷检测[15-16],如发动机的叶片等。

1. 基本原理

该技术主要是利用高功率超声波作为热激励源,超声波在试件内部传播引起内部裂纹摩擦生热、塑性变形、热弹效应等产生热量而引起试件缺陷区域局部温升,局部温升由于三维热扩散效应,温升区域热量从缺陷区域传递到试件表面,通过红外热像仪采集试件表面连续变化的温度信息,超声红外热成像技术原理示意图如图 1所示,主要包括红外热像仪、超声激励装置、图像处理和控制系统。最终根据采集到试件表面温度信号可以分析出试件内部缺陷的信息,从而可以实现试件内部缺陷信息的检测。

与其他激励方式红外热成像技术相比,超声激励红外热成像技术具有如下特点:一是超声激励不需要考虑热激励均匀性,属于选择性激励方式,仅对裂纹缺陷区域产生温升,对非缺陷区域基本不产生温升; 二是对复杂形状的试件依然可以取得较好的检测效果,不需要试件表面基本处于同一平面; 三是超声激励属于试件内部激励,相对于表面激励方式,热波传递到试件表面时间更短,更适合于检测出内部微小裂纹。

超声红外热成像技术对于航空发动机叶片内部裂纹比较有效,特别是对于叶片微小裂纹,裂纹更容易在超声激励作用下摩擦发热,由于三维热扩散,发热区域比实际裂纹区域要大,这将有助于微小裂纹的检测,而这种内部微小裂纹用其他方法难于有效检测。

2. 实验验证

2.1 实验平台系统

超声红外热成像实验平台系统实物如图 2所示,系统主要由超声激励源、超声发射器、超声枪、信号发生器、红外热像仪、结构支架、激光测振仪、计算机等组成。其中超声激励源包括超声驱动器、超声换能器及变幅杆等。激光测振仪主要用于测量试件表面振动信号,用于表征超声信号是否正常耦合进试件,信号发生器主要用于确保超声激励和红外热像仪采集之间的同步,以利于红外图像信号的处理和分析。红外热像仪正对航空发动机叶片试件,确保试件在红外热像仪视场中央,采集图像过程中不能移动叶片试件。计算机系统主要用于控制预紧力大小、热像仪采集时间、超声激励与采集同步、红外图像处理。

为了保证超声波能有效耦合进试件,需要超声枪头压在试件上,同时施加一定的预紧力,预紧力的大小需要通过压力传感器实时测量,从而能负反馈控制预紧力的大小。

超声枪的激励频率为20 kHz,激励功率为800 W,超声激励时间可设为200 ms~10 s,预紧力可设为0~2000 N,红外热像仪为FLIR公司生产的FLIR SC3000制冷热像仪,等效噪声温差(noise equivalent temperature difference, NETD)低于20 mK,探测波长范围8~9 μm,分辨率为320×240,采集帧频50 Hz。

2.2 航空发动机叶片

航空发动机叶片分为工作叶片和导向叶片,工作叶片称为转子叶片,导向叶片称为静子叶片,工作叶片位于导向叶片后方位置,如图 3所示。工作叶片需要承受较大的气流速度,因而工作叶片叶身厚,沿着叶高的截面变化相对明显,叶尖部分常常带有特殊构造,采用耐高温的镍基合金,在高温下有高的抗氧化和抗热腐蚀的能力,工作叶片的异形构造特性和表面涂层给实际检测带来了很大困难。

3. 实验结果对比

为了验证超声红外热成像检测效果,开展对比研究,分别采用渗透检测和金相技术对试件进行检测。

3.1 超声红外热成像结果

采用超声红外热成像技术对航空发动机工作叶片进行检测,实验中参数设置如下:超声激励时间设置为600 ms,超声激励预紧力设置为200 N,幅值输出设置100%,采集频率为50 Hz,采集时间3 s,采集帧数为150帧。选取采集序列中的6帧图像,如图 4所示,0 s时刻为超声激励前图像,是采集前背景图像,图 4中可以看出,缺陷从无到有、从逐渐变亮到逐渐变暗的过程,在超声激励过程中由于缺陷区域摩擦生热导致温度升高,超声激励结束后通过热传导效应传热至试件表面,热传导过程中会向三维方向扩散,热波在传播中会逐渐衰减,物理表现出热波强度逐渐减小、热波面积逐渐增大; 在红外图像中表现出亮斑区域逐渐扩大并逐渐消失的过程。

超声激励前背景图像为温度平衡基本处于稳态的过程,叶片表面温度基本一致,看不出缺陷信息,超声激励后有缺陷区域开始温升,0.5 s时刻亮斑区域较小,0.86 s时刻亮斑区域增大,1.2 s时刻亮斑区域增至最大,之后时刻亮斑区域强度逐渐变暗至消失。

从不同时刻检测到的序列图像中可以看出,该航空发动机工作叶片存在3个缺陷区域,提取3个缺陷区域的信息,得到缺陷标注图像,3个缺陷区域分别为①、②、③号缺陷,如图 5所示。

3.2 渗透检测结果

渗透检测是将一种荧光的渗透涂覆剂涂在试件表面,在毛细管现象的作用下,荧光渗透剂渗入表面开口的缺陷区域; 然后去除试件表面多余的荧光渗透液; 最后在试件表面喷上一层显像剂,同样在毛细管作用下,显像剂将缺陷区域的荧光渗透液回渗到显像剂中,在一定的光源下荧光渗透痕迹被显示,从而检测出缺陷,但渗透检测只能用于检测致密性试件且只能检测表面开口裂纹。

渗透检测结果如图 6所示,在叶片进气靠近叶尖位置看到1处裂纹,裂纹长度约1.5 mm,对应于超声红外热成像检测结果的缺陷①。

3.3 金相检测结果

为了验证超声红外热成像技术检测到的3个缺陷具体信息,采用金相显微镜对缺陷区域进行放大显示。

缺陷①金相显微镜放大图像结果如图 7所示,图 7(a)显示的是98×放大图像,图 7(b)显示的是1000×放大图像,从两个放大倍数的显微图像中都可以明显看到有裂纹,从图 7(b)中可以测量得到裂纹的宽度大致为15 μm。

缺陷②金相显微镜放大图像结果如图 8所示,图 8(a)显示的是98×放大图像,图 8(b)显示的是5000×放大图像,图 8(a)显微图像中无法看到缺陷裂纹图像,从图 8(b)显微图像像中可以明显看到有一裂纹缺陷,从图 8(b)中可以测量得到裂纹的宽度大致为0.5 μm。

3.4 结果对比分析

对于图 3所示的航空发动机工作叶片,超声红外热成像技术检测出了3个缺陷,缺陷编号分别是①、②、③,采用渗透检测,以荧光剂作为渗透液,仅检测出缺陷编号①的一处缺陷,采用金相显微镜对缺陷编号为①、②的缺陷放大,可以很清晰看到缺陷①处裂纹宽度约为15 μm,缺陷②处裂纹宽度约为0.5 μm,缺陷③从可见光图像观察可以明显看到有一开口缺陷。对于渗透检测的最小宽度裂纹,在理想情况下,侧壁绝对光滑、长宽比大于1、深宽比大于1的开口裂纹,理论上可以检测出0.1 μm宽度的缺陷裂纹。由于实际裂纹与理论上的裂纹存在差异,实际上的裂纹不会是理想中笔直的形状,且实际检测过程中存在外界条件、渗透液物理性能、渗透液化学性能、着色强度等干扰因素,因而采用渗透检测无法检测出约为0.5 μm宽度的缺陷②裂纹缺陷,但可检测出约为15 μm宽度缺陷①裂纹缺陷。对于超声红外热成像技术,由于缺陷②相比于缺陷①,裂纹缺陷宽度更窄,在20 kHz超声频率激励下,缺陷②摩擦振动的幅度比缺陷①摩擦振动的幅度更大,因而缺陷②局部温升比缺陷①局部温升高; 缺陷③为开口缺陷,开口处的不平整区域导致在超声激励下的摩擦生热等效应产生局部温升。

4. 结语

本文基于超声红外热成像技术对航空发动机叶片进行检测,该技术结合了超声激励技术与红外热像技术的优势,对试件表面的形状、粉尘及污染等不敏感。通过搭建的超声红外热成像实验平台检测了服役过程中产生裂纹的航空发动机叶片,实验结果表明,采用超声红外热成像技术可有效发现宽度约为0.5 μm的微小裂纹,渗透检测无法有效发现该微小裂纹。说明该技术在裂纹缺陷检测中有特殊的应用优势。

-

表 1 实验数据集构成

Table 1 Composition of experimental dataset

Configure KAIST FLIR RGBT Number of images 8600 11000 15000 Image size 512×512 512×512 640×480 Number of target categories 4 8 11 Train: Verification: Test 7:1:2 表 2 超参数设置

Table 2 Hyperparameter setting

Hyperparameter Value Batch size 4 Learning rate 0.01 Weight initialization Xavier Learning rate regulation Multistep Weight decay 0.005 Momentum 0.95 Weight adjustment strategy Adam Category loss calculation Cross Entropy Position loss calculation CIoU 表 3 基础特征提取结构对比

Table 3 Comparison of basic feature extraction structures

表 4 多源特征提取结构对比

Table 4 Comparison of multi-source feature extraction structures

Network Efficiency/fps Test accuracy/(%) mAP mAPs mAPm mAPl Dual branch extraction 17 76.2 57.1 76.5 85.3 Fusion extraction 33 74.9 55.6 75.1 82.8 Group extraction 30 77.5 58.3 77.8 86.9 表 5 注意力结构对比

Table 5 Comparison of attention structure

表 6 多尺度特征融合结构对比

Table 6 Comparison of multi-scale feature fusion structures

表 7 NMS改进前后对比

Table 7 Comparison of NMS before and after improvement

Network Efficiency/fps Test accuracy/(%) AP AP50 AP75 Before NMS optimization 27 60.5 87.5 60.4 After NMS optimization 27 61.0 88.8 61.3 表 8 同类型多源目标检测对比

Table 8 Comparison of same type multiple source object detection

表 9 FLIR数据集测试结果对比

Table 9 Comparison of FLIR dataset test results

-

[1] 杜紫薇, 周恒, 李承阳, 等. 面向深度卷积神经网络的小目标检测算法综述[J]. 计算机科学, 2022, 49(12): 205-218. DOI: 10.11896/jsjkx.220500260 DU Z W, ZHOU H, LI C Y, et al. A survey on small object detection algorithms for deep convolutional neural networks[J]. Computer Science, 2022, 49(12): 205-218. DOI: 10.11896/jsjkx.220500260

[2] 李科岑, 王晓强, 林浩, 等. 深度学习中的单阶段小目标检测方法综述[J]. 计算机科学与探索, 2022, 16(1): 41-58. LI K C, WANG X Q, LIN H, et al. A survey on single-stage small object detection methods in deep learning[J]. Journal of Computer Science and Exploration, 2022, 16(1): 41-58.

[3] LIANG Y, QIN G, SUN M, et al. Multi-modal interactive attention and dual progressive decoding network for RGB-D/T salient object detection[J]. Neurocomputing, 2022, 490: 132-145. DOI: 10.1016/j.neucom.2022.03.029

[4] 宋文姝, 侯建民, 崔雨勇. 基于多源信息融合的智能目标检测技术[J]. 电视技术, 2021, 45(6): 101-105. SONG W S, HOU J M, CUI Y Y. Intelligent object detection technology based on multi-source information fusion[J]. Television Technology, 2021, 45(6): 101-105.

[5] LIU J, FAN X, HUANG Z, et al. Target-aware dual adversarial learning and a multi-scenario multi-modality benchmark to fuse infrared and visible for object detection[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2022: 5802-5811.

[6] 吴泽, 缪小冬, 李伟文, 等. 基于红外可见光融合的低能见度道路目标检测算法[J]. 红外技术, 2022, 44(11): 1154-1160. http://hwjs.nvir.cn/article/id/4bac684b-eed1-4894-900f-ed97489995e6 WU Z, MIAO X D, LI W W, et al. Low-visibility road object detection algorithm based on infrared visible light fusion[J]. Infrared Technology, 2022, 44(11): 1154-1160. http://hwjs.nvir.cn/article/id/4bac684b-eed1-4894-900f-ed97489995e6

[7] Afyouni I, Al Aghbari Z, Razack R A. Multi-feature, multi-modal, and multi-source social event detection: a comprehensive survey[J]. Information Fusion, 2022, 79: 279-308. DOI: 10.1016/j.inffus.2021.10.013

[8] 程腾, 孙磊, 侯登超, 等. 基于特征融合的多层次多模态目标检测[J]. 汽车工程, 2021, 43(11): 1602-1610. CHENG T, SUN L, HOU D C, et al. Multi-level multi-modal object detection based on feature fusion[J]. Automotive Engineering, 2021, 43(11): 1602-1610.

[9] ZHANG L, WANG S, SUN H, et al. Research on dual mode target detection algorithm for embedded platform[J]. Complexity, 2021, 2021(8): 1-8. http://openurl.ebsco.com/contentitem/doi:10.1155%2F2024%2F9874354?sid=ebsco:plink:crawler&id=ebsco:doi:10.1155%2F2024%2F9874354

[10] 邝楚文, 何望. 基于红外与可见光图像的目标检测算法[J]. 红外技术, 2022, 44(9): 912-919. http://hwjs.nvir.cn/article/id/60c5ef39-1d9c-4918-842f-3d86b939f3a6 KUANG C W, HE W. Target detection algorithm based on infrared and visible light images[J]. Infrared Technology, 2022, 44(9): 912-919. http://hwjs.nvir.cn/article/id/60c5ef39-1d9c-4918-842f-3d86b939f3a6

[11] 马野, 吴振宇, 姜徐. 基于红外图像与可见光图像特征融合的目标检测算法[J]. 导弹与航天运载技术, 2022(5): 83-87. MA Y, WU Z Y, JIANG X. Target detection algorithm based on feature fusion of infrared and visible light images[J]. Missile and Space Vehicle Technology, 2022(5): 83-87.

[12] ZHANG D, YE M, LIU Y, et al. Multi-source unsupervised domain adaptation for object detection[J]. Information Fusion, 2022, 78: 138-148. http://www.sciencedirect.com/science/article/pii/S1566253521001895

[13] CHEN S, MA W, ZHANG L. Dual-bottleneck feature pyramid network for multiscale object detection[J]. Journal of Electronic Imaging, 2022, 31(1): 1-16. http://www.nstl.gov.cn/paper_detail.html?id=58c6ec4e74c19b48febf51e68105aea0

[14] TANG B. ASFF-YOLOv5: Multielement detection method for road traffic in UAV images based on multiscale feature fusion[J]. Remote Sensing, 2022, 14(14): 3498-3499. http://www.mdpi.com/2072-4292/14/14/3498

[15] Woo S, Park J, Lee J Y, et al. CBAM: Convolutional block attention module[C]//Proceedings of the European Conference on Computer Vision (ECCV), 2018: 3-19.

[16] LI C, LIANG X, LU Y, et al. RGB-T object tracking: benchmark and baseline[J]. Pattern Recognition, 2019, 96: 106977. http://doc.paperpass.com/patent/arXiv180508982.html

[17] LIN T Y, Maire M, Belongie S, et al. Microsoft COCO: Common objects in context[C]//Computer Vision–ECCV 2014: 13th European Conference, 2014: 740-755.

[18] MA N, ZHANG X, ZHENG H T, et al. Shufflenet v2: Practical guidelines for efficient cnn architecture design[C]//Proceedings of the European Conference on Computer Vision (ECCV), 2018: 116-131.

[19] HAN K, WANG Y, XU C, et al. GhostNets on heterogeneous devices via cheap operations[J]. International Journal of Computer Vision, 2022, 130(4): 1050-1069. DOI: 10.1007/s11263-022-01575-y

[20] Howard A, Sandler M, CHU G, et al. Searching for mobilenetv3[C]// Proceedings of the IEEE/CVF International Conference on Computer Vision, 2019: 1314-1324.

[21] WANG Q, WU B, ZHU P, et al. ECA-Net: efficient channel attention for deep convolutional neural networks[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2020: 11534-11542.

[22] Dosovitskiy A, Beyer L, Kolesnikov A, et al. An image is worth 16×16 words: transformers for image recognition at scale[C]//International Conference on Learning Representations, 2021: 331-368.

[23] Misra D, Nalamada T, Arasanipalai A U, et al. Rotate to attend: convolutional triplet attention module[C]//Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision, 2021: 3139-3148.

-

期刊类型引用(14)

1. 董荣伟. 基于ADRC的高精度红外热成像仪温度控制系统设计. 计算机测量与控制. 2024(07): 162-168+175 .  百度学术

百度学术

2. 李瑞,陈飞. 组合砌体墙损伤红外热像检测方法研究. 粉煤灰综合利用. 2024(05): 92-96 .  百度学术

百度学术

3. 沈久利,张玉存. 改进烟花算法计算热态轴类锻件内圆柱体空洞缺陷深度. 中国机械工程. 2023(04): 387-394 .  百度学术

百度学术

4. 温飞娟,温奇飞,龙樟,蒲京辰,邓荣. 基于超声红外热波技术的再制造零件裂纹检测研究现状. 材料导报. 2023(06): 169-176 .  百度学术

百度学术

5. 刘毅,储银贺,李波. 基于持续热激励红外检测的风机叶片腐蚀检测. 激光与红外. 2023(05): 716-722 .  百度学术

百度学术

6. 梁嘉辉,贾宇,汤雷,张盛行. 耦合压力加载对超声热激励效果影响研究. 水利水运工程学报. 2023(03): 104-110 .  百度学术

百度学术

7. 李胤,宋远佳,江海军,陈飞,张凯. 编织复合材料低速冲击损伤超声热成像检测. 红外技术. 2023(08): 876-883 .  本站查看

本站查看

8. 江海军,盛涛,郑金华,向苹. 超声红外热成像技术国内研究现状与进展. 红外技术. 2023(10): 1020-1028 .  本站查看

本站查看

9. 谢有浩,任杰,姜阔胜. 汽车散热器焊合率热成像检测系统. 河南科技大学学报(自然科学版). 2022(04): 41-45+6 .  百度学术

百度学术

10. 王浩,吴易泽,王涛. 基于阵列热风激励的航发叶片近表面缺陷红外检测方法. 红外技术. 2022(10): 1112-1117 .  本站查看

本站查看

11. 乔俊明. 大坝心墙河床段基座混凝土裂缝的远程红外监测. 无损检测. 2022(10): 35-39 .  百度学术

百度学术

12. 冯辅周,朱俊臻,李志农. 超声红外热像技术发展现状及其在航空材料缺陷检测中的应用. 航空制造技术. 2022(20): 36-53 .  百度学术

百度学术

13. 韩梦,尹嘉雯,黄军科,李伟,魏勤. 铝合金板疲劳微裂纹超声红外成像检测的数值及实验研究. 应用声学. 2022(05): 727-734 .  百度学术

百度学术

14. 蔡亮. 基于超声红外热波成像的桥梁结构损伤识别方法. 现代交通技术. 2022(06): 55-59 .  百度学术

百度学术

其他类型引用(7)

下载:

下载: