Histogram Equalization Algorithm Based on Sobel Gradient and Its Application on Infrared Images

-

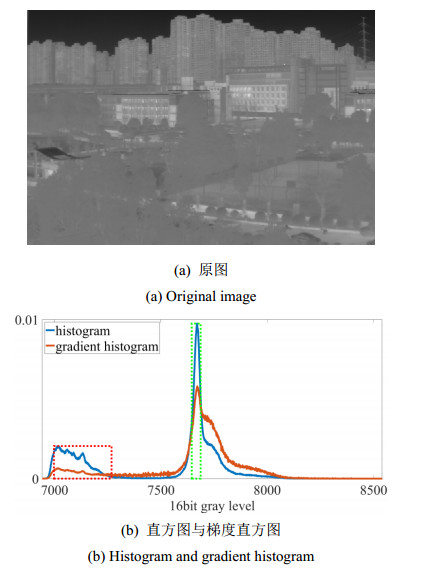

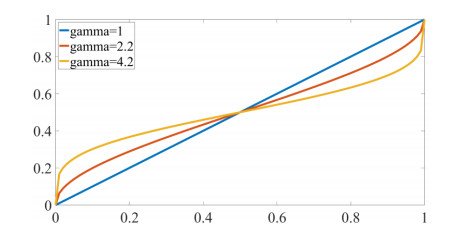

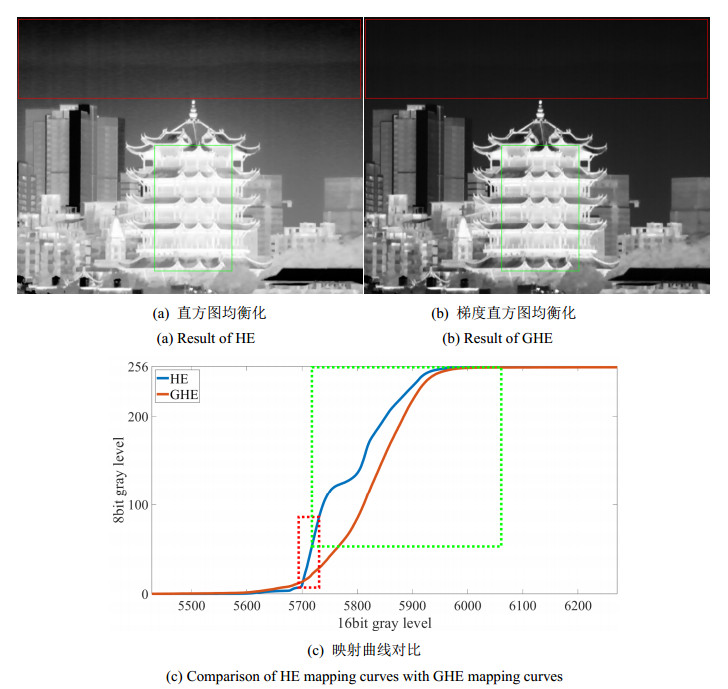

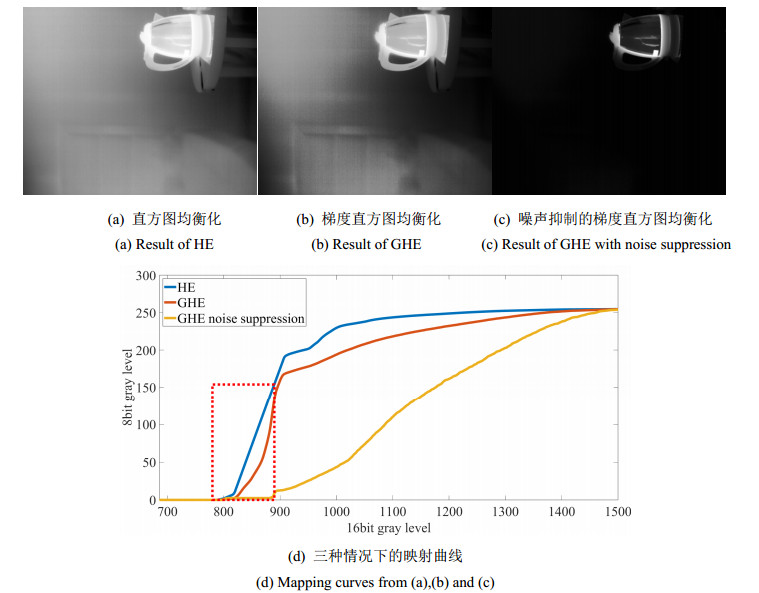

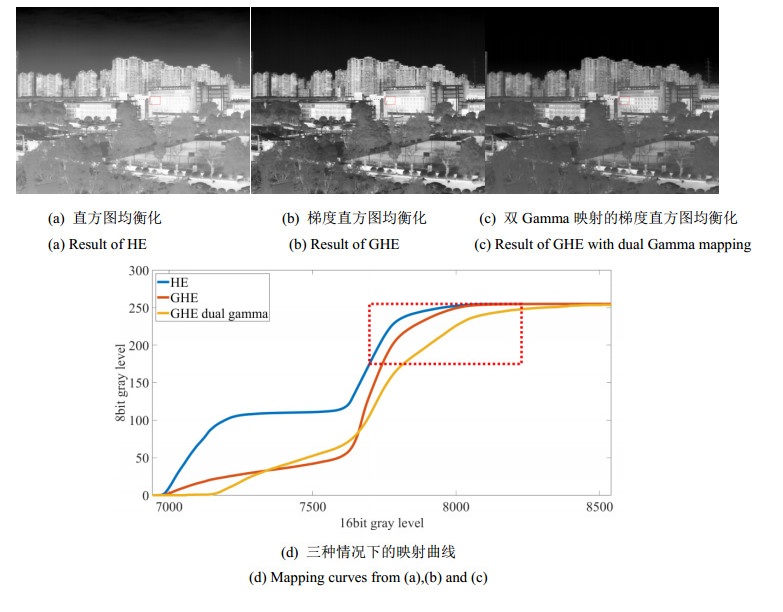

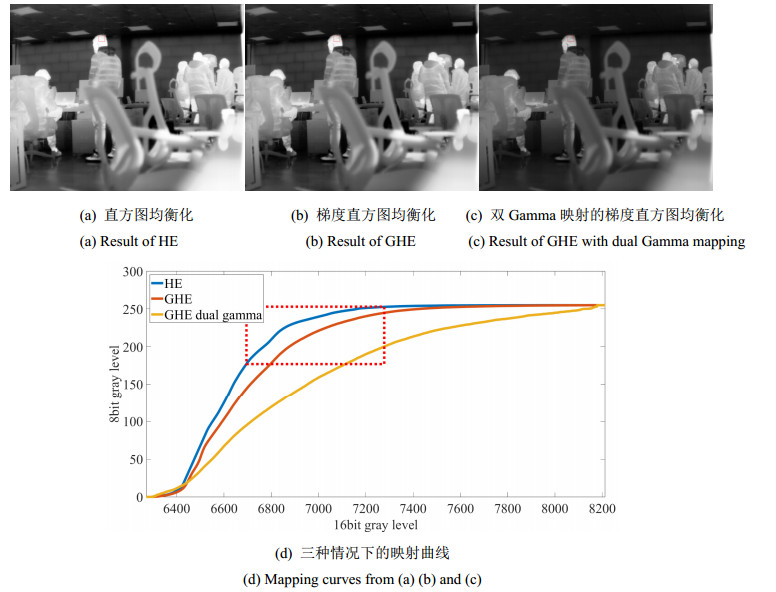

摘要: 为了能在动态范围压缩的同时增强红外图像的对比度,提出了一种基于Sobel梯度直方图均衡算法(gradient histogram equalization,GHE)。与以往的直方图均衡化(histogram equalization,HE)方法不同,该方法自适应地为图像强梯度的灰阶分配高对比度,保留并增强16 bit图像中更多的细节。随后使用双Gamma映射对映射曲线进行调整,有效地抑制图像亮部的过曝现象,同时提高暗部的细节。该方法相比于传统的直方图均衡化算法在暗区细节处理、过曝抑制、对比度增强等方面都有较好的效果。Abstract: A Sobel gradient histogram equalization(GHE) algorithm is proposed to enhance the contrast of infrared images during dynamic range compression. In contrast to previous histogram equalization(HE) methods, this method adaptively assigns a high contrast to the strongly graded parts of the image, preserving and enhancing more details in the 16-bit image. Dual Gamma mapping is then used to adjust the mapping curve to effectively suppress overexposure in the bright parts of the image while improving the detail in the shadows. Compared with the traditional histogram equalization algorithm, this method has better effects on dark area detail processing, overexposure suppression, and contrast enhancement.

-

Keywords:

- infrared image /

- gradient histogram equalization /

- dual Gamma mapping

-

0. 引言

目标识别技术是计算机视觉领域的重要研究方向之一。但是在可见光效果较差的环境下,传统的可见光目标检测技术往往难以达到良好的效果,使用红外成像在夜间或低光环境下比可见光成像效果更好[1],因此红外目标检测在安防、军事等领域中有着广泛的应用。

随着在机器视觉领域引入深度学习,目标检测技术取得了快速发展,基于深度学习的目标检测方法解决了传统机器学习检测精度低、漏检率高、检测速率低的问题。基于深度学习的目标检测算法按其网络体系结构,主要分为单阶段检测算法及双阶段网络算法,但经大量研究证实了双阶段目标检测算法可以在红外图像下进行目标检测,但过程繁琐,且需要大量重复性实验。随着YOLOv3[2]、YOLOv4[3]、YOLOv5的先后提出,YOLO[4]系列算法在精度和速度上对比同单阶段算法有着较大的优势,YOLOv5s算法作为YOLO系列算法比较成熟且模型体积较小的目标检测算法,对红外图像进行目标识别有着较好的表现,但因红外图像的图像特性,在检测速率、精度上还尚有改进空间。

本文基于YOLOv5s[5]算法,提出了以下几点改进:

1)引入了Ghost网络,并将NWD loss(Normalized Wasserstein Distance loss)损失函数融入至Ghost网络中,Ghost模型减少模型参数的同时可以提高YOLOv5s的性能,将损失函数替换为NWD loss,在不影响模型参数量的同时提高了模型的精度。

2)添加注意力机制CA,CA不仅考虑了通道信息,还考虑了方向相关的位置信息,且能够简单地插入到轻量级网络的核心模块中。

3)添加了加权双向特征金字塔BiFPN,BiFPN具有高效的双向跨尺度连接和加权特征融合,可以实现更多的特征融合。

1. 算法理论分析

1.1 YOLOv5目标检测算法

YOLOv5算法是一种轻量化的目标检测算法,其网络结构由输入端、主干网络、颈部和检测网络组成。YOLOv5算法具有4个不同深度和宽度的网络,分别为YOLOv5s、YOLOv5m、YOLOv5l和YOLOv5x,其中YOLOv5s是深度最小、特征图宽度最小且训练速度最快的网络。该算法具有高准确性和较快的训练速度,适用于移动端和嵌入式设备的实时目标检测应用。

1.2 Ghost Bottleneck模块

Ghost Bottleneck[6]是一种轻量化的卷积神经网络结构,旨在减少计算量和参数数量的同时,提高模型的精度和鲁棒性。如图 1为Ghost Bottleneck模块原理图,Ghost Bottleneck主要由两个Ghost模块叠加而成,第一个模块用于增加t通道数量,而第二个模块则用于减少通道数量,Ghost Bottleneck包含stride=1和stride=2两个版本,stride=1时不进行下采样,直接进行两个Ghost卷积操作;stride=2时shortcut路径下进行下采样,并在Ghost模块中加入一个步长为2的深度卷积操作,通过这种方式,Ghost Bottleneck可以在保证特征提取效果的同时,大幅减少参数数量和计算量。其中Ghost module模块原理图如图 2所示。

1.3 NWD Loss

NWD loss[7]是一种用于目标检测任务的损失函数。NWD loss是基于Wasserstein距离的思想,旨在降低不同尺度物体之间的特征差异,提高目标检测的准确性。相比于传统的均方误差(Mean Squared Error)损失函数,NWD loss可以更好地适应物体检测任务中不同尺度物体的特征差异,从而更好地优化模型。在NWD loss中,Wasserstein距离是在两个分布之间计算的,这里的分布指的是特征图上的物体分布。通过计算分布之间的Wasserstein距离,可以度量两个分布之间的相似度,从而用作损失函数的衡量标准。

NWD:

$$ {\text{NWD}}({N_{\text{p}}}, {N_{\text{g}}}) = \exp ( - \frac{{\sqrt {(W_2^2({N_{\text{a}}}, {N_{\text{b}}})} }}{C}) $$ (1) NWD loss:

$$ L_{\mathrm{NWD}}=1-\mathrm{NWD}\left(N_{\mathrm{p}}, N_{\mathrm{g}}\right) $$ (2) 式中:Np是预测框的高斯分布;Ng是GT框的高斯分布;C是一个常数,和数据集有关。

1.4 注意力机制CA

Coordinate Attention[8](CA)是一种新颖的移动网络注意力机制,CA注意力很简单,可以灵活地插入到经典的移动网络中,而且几乎没有计算开销。CA框图如图 3所示。

为了使注意力模块能够捕捉具有精确位置信息的远程空间交互,CA按照以下公式分解了全局池化。

转化为一对一维特征编码操作:

$$ {z_c} = 1\frac{1}{{H \times W}}{\text{ }}\sum\limits_{i = 1}^H {\sum\limits_{j = 1}^W {{x_c}(i, j)} } $$ (3) 高度为h的第c通道的输出:

$$ z_c^h(h) = \frac{1}{W} \sum\limits_{0 \leqslant i < W}^{} {{x_c}(h, i)} $$ (4) 宽度为w的第c通道的输出:

$$ z_c^h(h) = \frac{1}{H}{\text{ }}\sum\limits_{0 \leqslant i < H}^{} {{x_c}(j, w)} $$ (5) 对尺寸为C×H×W输入特征图Input分别按X方向和Y方向进行池化,分别生成尺寸C×H×1和C×1×W的特征图,如图 4所示。

将生成的C×1×W的特征图进行变换,然后进行Concat操作:

$$ f = \delta ({F_1}([{z^h}, {z^w}])) $$ (6) Coordinate Attention Block的输出Y:

$$ {y_c}(i, j) = {x_c}(i, j) \times g_c^h(i) \times g_c^w(j) $$ (7) 1.5 加权双向特征金字塔BiFPN

Bipartite Feedforward Networks(BiFPN)是一种新型的神经网络结构,它可以应用于计算机视觉任务中的特征提取。BiFPN[9]不同于其他的FPN结构(不同分辨率的特征融合时直接相加),在PANet[10]的基础上,若输入和输出都是同一水平,则添加一条额外的边。EfficientDet[11]为解决因不同的特征具有不同的分辨率,对特征融合的贡献不平等的问题,提出在特征融合期间为每个输入添加一个额外的权重,让网络去学习每个输入特征的重要性。如图 5所示,BiFPN做了两个方面的改进:

1)PANet进行特征融合时,是通过Concat的,一般高层和低层的特征贡献程度相同,BiFPN在特征融合时,通过一组可学习的归一化权重参数调整各层贡献程度。

2)BiFPN堆叠多层实现更高维度的特征融合。

2. 网络模型优化

2.1 骨干网络模块替换

使用Ghost Bottleneck模块替代原始YOLOv5s网络结构中的C3模块以及Conv模块。YOLOv5s改进模型算法网络结构示意图和模块替换示意图如图 6所示。具体而言,第三层C3模块用step=1的Ghost Bottleneck模块替代;第二层、第四层、第六层和第八层的Conv模块用step=2的Ghost Bottleneck模块替代,以降低模型参数数量;第五层、第七层及第九层的C3模块则用3个step=1的Ghost Bottleneck模块替换。将本次改进后的模型YOLOV5-Ghost称为YOLOv5-CG。

2.2 损失函数替换

CIOU loss[12]无法对目标的长宽比进行很好的处理,导致对于形状较为特殊的目标,检测精度可能不如NWD loss,且CIoU损失函数未考虑难易样本的平衡问题。NWD loss可以对目标之间的相似性进行更准确的度量,并且可以自适应地调整样本的难易程度,从而提高模型的泛化能力。

因此将Ghost网络模块回归的损失由原始CIoU Loss替换为NWD Loss,将替换后的模型称为YOLOv5-GN,通过实验证明,模型表现较好。

2.3 注意力模块CA添加

为提升模型训练过程中对训练图像不同区域信息学习效率,因此在不同尺寸的特征图后添加注意力CA模块,将CA放在Backbone部分的最末端,即在第十层的输出端添加CA模块,这样可以使注意力机制看到整个Backbone部分的特征图,使得特征图的深度加权平均,提升网络模型的精度,同时较好地提升模型学习效率。

2.4 引入双向特征金字塔网络BiFPN

将BiFPN添加到Neck部分的第十层,BiFPN引入了跳跃连接,即在相同尺度的输入节点到输出节点中间再增加1个跳跃连接,因为运算处于相同层,该方法可在参数较少的同时结合更多特征。BIFPN将每一条双向路径视作1个特征网络层,并对同一层参数进行多次计算,以实现更多的特征融合。

3. 实验验证及性能风险

3.1 实验平台环境

本文实验是基于Windows10操作系统下进行实验验证。训练平台采用Nvidia GeForce RTX 3090(24 GB/微星),13th Gen Intel(R) Core(TM) i7-13700K CPU @ 3.40 GHz处理器,语言为Python3.7,加速环境为CUDA11.6,深度学习网络框架为Pytorch。测试部署平台采用Jetson AGX Orin 32 GB,该开发板具备支持多个并发AI推理管线的200TOPS算力,外形小巧,性能出色。该开发板具备8核Arm® Cortex®-A78AE v8.2 64位CPU 2 MB L2+4 MB L3,GPU采用搭载56个Tensor Core的1792核NVIDIA Ampere架构GPU。

3.2 实验数据及参数说明

本文训练验证采用数据集为InfiRay[13]提供的红外航拍人车检测数据集,数据库使用person、car、bus、cyclist、bike、truck分别作为行人、小汽车、公交车、骑自行车的人、自行车、卡车的标签。验证训练集11045张、验证集2000张、测试集550张。网络模型部分重要训练参数设置如下:训练轮次为300,批尺寸为16,初始学习率为0.01,周期学习率为0.01,学习率动量为0.937,权重衰减系数为0.0005。

3.3 网络模型的评价指标

本文对模型训练的评价指标主要从以下几方面分析:精确率(Precision):是指预测为正例中真正为正例的样本数占所有预测正例的样本数的比例;召回率(Recall):是指真正为正例中预测为正例的样本数占所有真正为正例的样本数的比例;平均精度[14](Mean Average Precision,mAP):是对所有类别的AP取平均得到的指标;F1分数(F1-score):是衡量模型准确率和召回率之间平衡的指标,F1分数越高,代表模型综合表现越好。帧率(FPS):每秒传输帧数,YOLOv5的帧率计算主要为以下3个参数:图像预处理时间(pre-process)、推理速度[15]、后处理时间,FPS即1000 ms除以这3个时间之和。其中TP表示被模型预测为正类的正样本数量,FN表示被模型预测为负类的正样本数量,AP表示平均准确度,N表示总的类别数。即预测为正例且正确的样本数除以预测为正例的样本数。

$$ \text{Precision} = \frac{{{\text{TP}}}}{{{\text{TP + FP}}}} $$ (8) $$ \text{Re} {\text{call}} = \frac{{{\text{FP}}}}{{{\text{TP + FN}}}} $$ (9) $$ {\text{mAP}} = \frac{{\sum\limits_{i = 1}^N {{\text{AP}}} }}{N} $$ (10) $$ {\text{F1-score}} = 2 \times \frac{{{\text{precision}} \times {\text{recall}}}}{{{\text{precision + recall}}}} $$ (11) $$ {\text{FPS}} = \frac{{1000}}{{{\text{pre - process + ms inference + NMS}}}} $$ (12) 3.4 实验结果及性能分析

将改进后的模型训练所得的results.txt文件,使用Matlab软件提取有效信息,并对关键数据进行可视化展示,消融实验分两组对比,其中一组对比各模型的精准率、召回率、mAP@0.5、mAP@0.5: 0.95。另一组对比各模型的mAP@0.5、FPS、权重文件大小。为了更直观地感受检测效果,在两个场景下对各模型的检测效果做展示。

3.4.1 消融实验

为验证本文改进算法的有效性,在相同数据集上进行了消融实验。在YOLOv5s原模型的基础上,依次进行修改:引入Ghost主干网络(YOLOv5s-GC);引入替换NWD loss的Ghost(YOLOv5s-GN);引入CA和BiPFN注意力机制(YOLOv5s-CB)。消融实验结果如表 1所示。从表 1中实验结果可以看出,YOLOv5s-GC mAP@0.5提高了3%,FPS增加了8.1;YOLOv5s-GN mAP@0.5上升了3.2%,FPS增加了7.51;YOLOv5s-CB mAP@0.5上升3.3%,F1提升了3,但FPS下降了3.2。对比YOLOv5s-GN-CB与YOLOv5s原模型,mAP@0.5上升4.2%,F1提升了4,FPS上升了8.1,综上所述证明,本文所改进方法的有效性,在提高模型平均精度的同时,提高了模型计算速度,减少耗时,提高了检测实时性。

表 1 消融实验结果对比Table 1. Comparison of ablation experimental resultsModels mAP@0.5 F1 FPS YOLOv5s 90.9 87 67.114 YOLOv5s- GC 93.9 89 75.188 YOLOv5s- GN 94.1 89 74.627 YOLOv5s- CB 94.2 90 44.053 YOLOv5s- GN-CB 95.1 91 75.188 3.4.2 部分检测结果示例

为了更直观地验证改进后的YOLOv5s-GN-CB模型的检测效果,本文用各改进算法分别对两个不同场景进行了红外人车检测验证,场景a包括了多个分类,场景b下虽分类不多但框图多,分别对两种场景10组检测结果进行了对比,检测结果图像如图 7所示,每组检测结果中,第一列为原YOLOv5s检测结果,最后一列为改进的YOLOv5s-GN-CB检测结果。通过检测结果可以看出YOLOv5s-GN-CB检测精度更高,特征提取能力有所增强,在不同场景下的检测均有一定提高。

3.4.3 对比实验

为了更加客观地评价本章所改进的YOLOv5s模型在红外场景检测中的效果,本文将改进后的YOLOv5s模型与其它YOLOv5主流算法进行了对比,包括原YOLOv5s、YOLOv5s-Ghost(GC)[16]、YOLOv5s-GN、YOLOv5s-MobileNetV3[17]、YOLO v5x,实验过程遵循控制变量原则,实验软硬件环境保持一致。评价指标采用平均准确率(mAP)、每秒帧数(FPS)、权重文件大小(MB)。实验结果如表 2所示,通过实验结果可以看出,Ours相对于YOLOv5s mAP@0.5提高了3.2%,FPS增加了8.1;相对于YOLOv5s-Ghost mAP@0.5上升了2.2%;相对于YOLOv5s-GN mAP@0.5上升1%;相对YOLOv5s-MobileNetV3 mAP@0.5上升3.1%,FPS上升了19;虽然mAP@0.5对比YOLOv5x略有下降,但在FPS及权重文件大小上有较大优势。图 8显示了与其它YOLOv5主流算法的参数变化对比,通过观察图表可以看出本文改进的算法在平均精度、帧率及权重大小上具有显著优势。

表 2 主流算法对比实验结果Table 2. Comparative experiments with mainstream algorithmsModels mAP@0.5/ (%) FPS/(frame/s) Weight coefficient/MB YOLOv5s 90.9 67.114 3.69 YOLOv5s-Ghost 93.9 75.188 7.44 YOLOv5s-GN 94.1 75.188 11.5 YOLOv5s-MobileNetV3 92.0 56.180 7.31 YOLOv5x 97.7 14.164 171 Ours 95.1 75.188 11.6 4. 结语

本文提出一种基于改进YOLOv5s的红外人车目标检测的优化算法,改进后YOLOv5s-GN-CB模型应用于红外场景下对人车等多种分类进行检测分类。实验将模型部署至Jetson AGX Orin平台经测试模型,使用改进后算法对红外场景下的航拍人车进行目标识别mAP@0.5可达到95.1%,FPS为75.188帧/s,模型产生的权重文件为11.6 MB。实验表明,相对于原YOLOv5s模型,改进后的模型在利于便携式嵌入式设备的情况下可有效提高平均精度和FPS。此研究对增强无人机在夜间飞行过程中对周围环境的检测能力,推动无人机的发展具有重要意义。

-

表 1 两种算法对比度对比

Table 1 Comparison of HE with GHE

Algorithms Sky Architecture Picture HE 3.74 54.33 74.14 GHE 0.19 123.96 98.19 -

[1] LIU C, SUI X, KUANG X, et al. Optimized contrast enhancement for infrared images based on global and local histogram specification[J]. Remote Sensing, 2019, 11(7): 849. DOI: 10.3390/rs11070849

[2] 李凌杰, 陈菲菲. 基于改进直方图的红外图像增强方法[J]. 航空兵器, 2022, 29(2): 101-105. https://www.cnki.com.cn/Article/CJFDTOTAL-HKBQ202202015.htm LI Lingjie, CHEN Feifei. Infrared image enhancement method based on improved histogram[J]. Aero Weaponary, 2022, 29(2): 101-105. https://www.cnki.com.cn/Article/CJFDTOTAL-HKBQ202202015.htm

[3] CHEN X, LV L. A compositive contrast enhancement algorithm of IR image[C]//International Conference on Information Technology & Applications of IEEE, 2013, DOI: 10.1109/ITA.2013.20

[4] LIU N, CHEN X. Infrared image detail enhancement approach based on improved joint bilateral filter[J]. Infrared Physics & Technology, 2016, 77: 405-413.

[5] HUANG Z, ZHANG T, LI Q, et al. Adaptive gamma correction based on cumulative histogram for enhancing near-infrared images[J]. Infrared Physics & Technology, 2016, 79: 205-215.

[6] JUNG C, LU W. Tone-preserving contrast enhancement in images using rational tone mapping and constrained optimization[C/OL]. 2016 IEEE Visual Communications and Image Processing, https://ieeexplore.ieee.org/document/7805525.

[7] LI S, JIN W, LI L, et al. An improved contrast enhancement algorithm for infrared images based on adaptive double plateaus histogram equalization[J]. Infrared Physics & Technology, 2018, 90: 164-174.

[8] Hum Y C, Tee Y K, W. -S. Y, et al. A contrast enhancement framework under uncontrolled environments based on just noticeable difference[J]. Signal Processing, 2022, 103: 116657

[9] Bae J, Kim K, Yun Y J, et al. Adaptive tone-mapping operator for HDR images based on image statistics[C]//Proc. of IEEE, 2011, DOI: 10.1109/TENCON.2011.6129047

[10] DENG Weitao, LIU Lei, CHEN Huateng, et al. Infrared image contrast enhancement using adaptive histogram correction framework[J]. Optik, 2022, 271: 170114. DOI: 10.1016/j.ijleo.2022.170114

[11] Arici T, Dikbas S, Altunbasak Y. A histogram modification framework and its application for image contrast enhancement[J]. IEEE Trans Image Process, 2009, 18(9): 1921-1935. DOI: 10.1109/TIP.2009.2021548

[12] Ok J, Lee C. HDR tone mapping algorithm based on difference compression with adaptive reference values[J]. Journal of Visual Communication and Image Representation, 2016, 43: 61-76.

[13] Arici T, Dikbas S, Altunbasak Y. A histogram modification framework and its application for image contrast enhancement[J]. IEEE Trans Image Process, 2009, 18(9): 1921-1935. DOI: 10.1109/TIP.2009.2021548

[14] Lee S. An efficient content-based image enhancement in the compressed domain using Retinex theory[J]. IEEE Transactions on Circuits & Systems for Video Technology, 2007, 17(2): 199-213.

-

期刊类型引用(5)

1. 刘晏长. 装配式钢结构建筑抗侧力支架缺陷超像素级Gabor识别方法. 无损检测. 2025(04): 33-38 .  百度学术

百度学术

2. 杨超,孙虎,唐超. 电磁脉冲涡流检测下金属管道缺陷检测研究. 电子测量与仪器学报. 2025(04): 132-140 .  百度学术

百度学术

3. 胡光锋. 基于红外热成像技术的动车组关键部位表面伤痕检测方法. 现代制造技术与装备. 2024(02): 92-94 .  百度学术

百度学术

4. 张玉彬,陈丽娜,刘鹏谦,赵擎,刘蕊,王龙博,谢静,徐长航. CFRP-钢胶接结构内部损伤的增强型电磁感应热成像检测. 复合材料学报. 2024(09): 5004-5015 .  百度学术

百度学术

5. 周鹍,郭俊鑫,罗杰,李云红,李丽敏,苏雪平,侯乐乐. 基于红外测温数据的水电站设备缺陷检测方法. 红外技术. 2024(11): 1308-1314 .  本站查看

本站查看

其他类型引用(5)

下载:

下载: