Identification of Pipeline Thermal Image Leakage Based on Deep Learning

-

摘要:

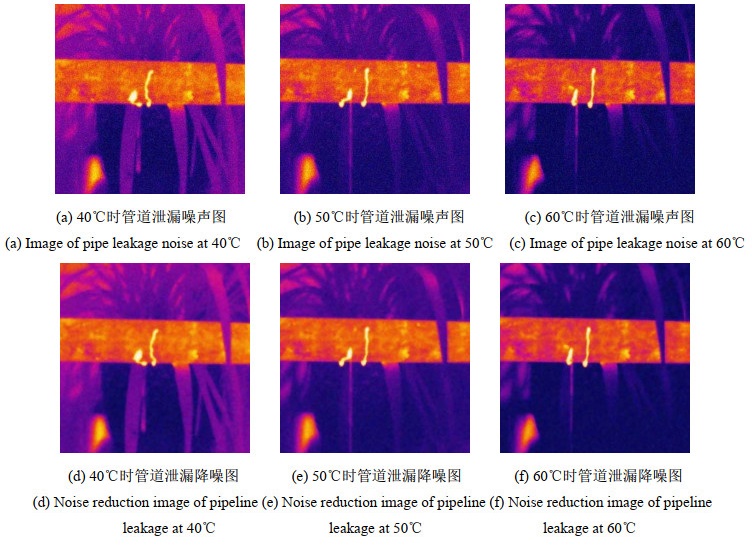

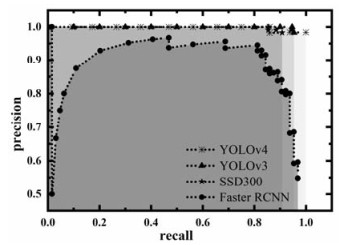

为了降低输液管道多泄漏点微小泄漏的检测难度,提高输液管道无损检测的检测精度与检测速度,通过搭建水循环管道泄漏实验系统,改变管道泄漏点尺寸、泄漏点数量及输送介质温度,应用红外热像仪实时采集红外图像,提出基于非线性平稳小波和双边滤波算法实现图像降噪;并结合红外检测技术和YOLO(You Only Look Once)v4模型实现输液管道单、多漏点的自动化智能检测。结果表明,与传统滤波算法相比,该降噪方法的峰值信噪比、结构相似性均有所提升;该模型能够快速且准确地检测管道单、多漏点,检测精度(mAP)分别达到了0.9822及0.98,准确率分别达到了98.3%及98.36%,单帧检测时间分别达到了0.3021 s及0.3096 s,实现了在复杂背景干扰下对单、多泄漏点的识别。通过与YOLO v3、Faster R-CNN和SSD 300这3种算法比较发现,YOLO v4算法对管道单一漏点及多泄漏点检测的准确率、mAP和检测时间均更佳,具有更高的检测准确性与检测效率。

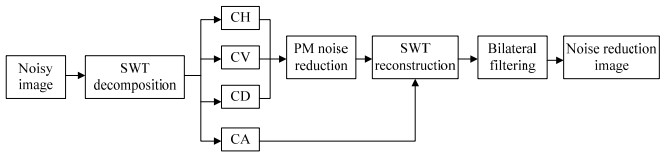

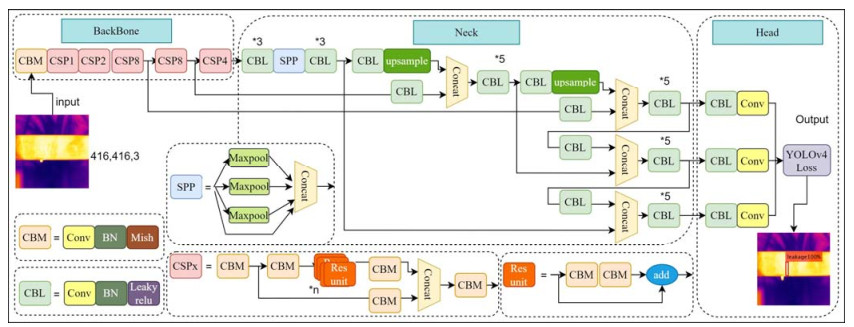

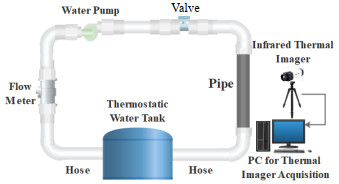

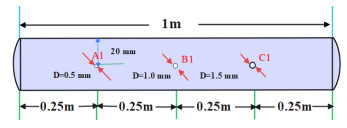

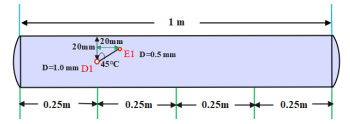

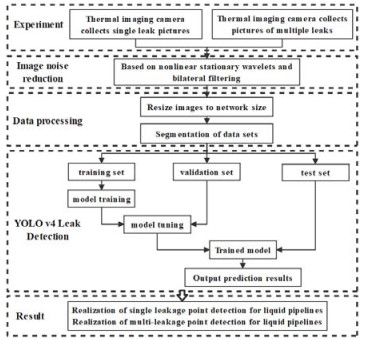

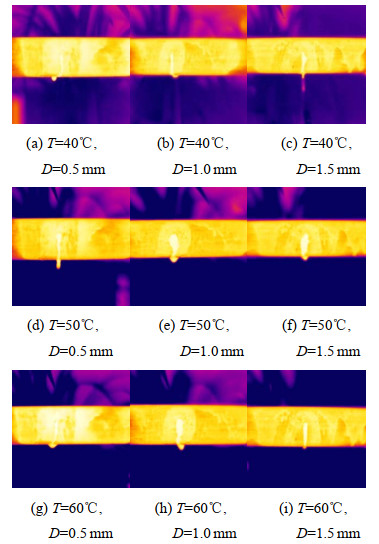

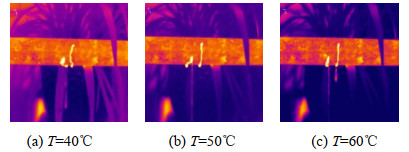

Abstract:To reduce the difficulty of detecting tiny leakages at multiple leakage points in liquid pipelines, it is necessary to improve the detection accuracy and speed of the leakage points. Bilateral filtering based on nonlinear stationary wavelets is proposed to achieve image noise reduction by building a water circulation pipeline leakage experiment system, changing the sizes and number of the leakage points, changing the temperature of the conveying medium, and applying an infrared thermal imager to monitor the small leakage of the single and complex leakage points. Combined with infrared nondestructive testing technology and a YOLO v4 network model, this study realized the automatic intelligent detection of single and multiple leakage points of liquid pipelines. The results show that compared with the traditional filtering algorithm, the peak signal to noise ratio and structural similarity evaluation indexes of the noise reduction method are improved. The model can quickly and accurately detect and locate single and multiple leakage points of pipelines. The average detection accuracy (mAP) values of the single and multiple leakage points in complex environment reach 0.9822 and 0.98, respectively. Further, the accuracy rates reach 98.3% and 98.36%, and the single frame detection times reach 0.3021 s and 0.3096 s, respectively. This helps realize the identification of leakage points under complex background interference. In comparison with YOLO v3, Faster R-CNN, and SSD 300, the YOLO v4 algorithm has better accuracy, mAP, and t for the detection of single and multiple leakage points and has a higher detection accuracy and detection efficiency.

-

0. 引言

人类的视觉感知系统能够捕获场景中的重要物体和场景信息,如颜色、轮廓、景深等属性,通过处理和整合这些信息,人类可以在各种场景下迅速定位感兴趣的区域,即显著性区域。显著性目标检测就是模拟上述过程,赋予计算机系统快速定位重要目标、感知场景重要信息的能力,已经被广泛应用于图像分类[1]、语义分割[2]和目标识别[3]等众多计算机视觉任务。

显著性目标检测最早在1998年被Itti等人[4]提出。此后一段时间内,显著性目标检测虽然得到了一定的发展,但面对复杂背景、光照变化等挑战性因素难以取得理想效果。近年来,随着热红外传感器的发展和普及,一些研究发现热红外信息在处理照明条件、复杂背景等因素导致的目标模糊问题时具有很好的效果[5-6],非常适合处理低光、雨雾天气等恶劣条件拍摄的图像。为了提升显著性目标检测的性能,一些学者以RGB和热力信息为输入,设计了RGB-T显著性目标检测方法[7-8]。2017年Ma等人[8]提出了首个RGB-T显著性目标检测方法(Multiscale Features and SVM Regressors,MFSR),该方法利用VGG16分别生成RGB和热力图像的显著预测,然后训练一个支持向量机来有权重地融合两个显著图,验证了热力信息能够有效提升检测的效果。自此开始,一系列RGB-T显著性目标检测方法被先后提出[9-11],但目前仍没有相关的综述对现有的方法进行梳理。鉴于此,本文首次对RGB-T显著性目标检测进行系统全面的综述,旨在总结这些方法、梳理脉络、了解其当前发展趋势、探明未来发展方向与研究重点,为RGB-T显著性目标检测的发展提供参考。

如图 1所示,RGB-T显著性目标检测可分为基于机器学习和基于深度学习两类方法。以Wang等人[7]提出的首个方法MTMR(Multi-task Manifold Ranking)为例,基于机器学习的RGB-T显著性目标检测方法存在方法单一、鲁棒性差的问题,面对复杂情况往往效果较差甚至失效。以Ma等人[8]提出的首个方法MFSR为例,基于深度学习的RGB-T显著性方法具有端到端学习、可扩展性强等诸多优点,非常适合处理大规模复杂数据,目前已成为RGB-T显著性目标检测中的主流,也是本文重点阐述的内容。图 2展示了RGB-T显著性目标检测发展时间线。

1. RGB-T显著性目标检测方法

1.1 基于机器学习的RGB-T显著性目标检测

现有基于机器学习的RGB-T显著性目标检测都采用图流形排序(Graph-based Mainfold Ranking,GMR)算法。2004年,Zhou等人[9]首次提出了流形排序的概念。简单来说,流形排序以传播和迭代的方式计算出数据集中数据点成为“中心类”的可能性,而GMR以图模型构建数据点进行流形排序。2018年,Wang等人[7]首次将GMR引入RGB-T显著性目标检测中,提出了MTMR算法。MTMR将热力信息视为RGB图像额外的通道,利用图像的超像素作为初始节点,以边界节点作为背景类进行流形排序定位显著区域,再以显著区域中的节点作为显著中心进行流形排序,并根据模态可靠性和一致性自适应地融合双模态信息。此外,他们还提出了首个被广泛使用的RGB-T显著性目标检测数据集VT821[7],为后续的研究奠定了基础。

在GMR算法中,节点的选择和排序算法会对预测结果起重要影响。Tu等人[10]针对边界噪声和真实场景中的目标存在大小或内外部不一致的情况提出一个多尺度噪声不敏感的方法。该方法利用多粒度超像素分割获取多尺度图节点,并通过引入中间变量优化了节点选择的过程,从而降低了显著性结果的边界噪声,且面对处于边界的目标取得了较好的效果。Huang等人[11]设计了一个低秩亲和矩阵来建模超像素关系,并在流形排序之前根据亲和矩阵和学习重要特征,结合多模态一致性和异构性自适应地融合多模态特征。Huang等人[12]基于双模态的边界信息捕获了更精确的超像素,并提出了多图融合模型来选择性地从多模态图像中学习有用信息。

简言之,此类方法均需要通过人为设计提取出有用的特征,严重依赖设计者的经验和水平,设计者往往需要耗费大量的人力和时间来进行特征设计和调优,在面对复杂场景下的检测效果不佳,存在目标模糊、检测错误、检测缺失等问题。

1.2 基于深度学习的RGB-T显著性目标检测

相较于机器学习,深度学习在自动提取特征、处理复杂数据、可扩展性、端到端学习、模型容量等方面均更具优势,在计算机视觉领域获得了巨大成功[13-14],也被引入RGB-T显著性目标检测中,尤其以卷积神经网络(Convolutional Neural Networks,CNN)和Vision Transformer(ViT)的表现优异。本章将分别介绍基于CNN和基于ViT的RGB-T显著性目标检测方法。

1.2.1 基于CNN的RGB-T显著性目标检测

CNN的特点是对图像的局部信息比较敏感,模型结构相对简单、参数较少,非常适合显著性目标检测任务。2017年,Ma等人[7]提出了第一个基于CNN的RGB-T显著性目标检测的方法MFSR,随后出现了引入注意力机制、探索上下文信息等基于不同设计的方法。本文将这些方法进一步分为基于超像素的方法、基于特征增强的方法和基于特征融合的方法3类。

1)基于超像素的方法。超像素是基于机器学习的RGB-T显著性目标检测中最常用的结构。为了克服此类方法通过人为设计提取特征的局限,部分学者引入CNN特征探索超像素之间的关系。Tu等人[15]使用VGG19提取特征,在每个模态的多层次特征上进行流形排序,并利用亲和力矩阵提出了一种联合图学习(Saliency Detection via Collaborative Graph Learning,SDCGL)方法。Pang等人[16]基于背景的加权图来初步定位深度特征的显著性区域,再利用设计的跨模态协同反馈细胞自动机(Cross-modal Co-feedback Cellular Automata)细化显著目标。不同于上述方法利用深度特征建模超像素关系,Liu等人[17]提出了一个基于涂鸦的弱监督框架,通过涂鸦区域的超像素来定位目标,约束双模态深层特征分别生成显著性预测,预测图被聚合为伪标签用于监督目标网络的显著性预测结果。

尽管上述方法利用深度特征克服了手工特征(hand-crafted feature)的局限性,但是仍然存在检测精度不理想、边界粗糙等问题,其检测结果也呈现明显的超像素纹理。

2)基于特征增强的方法。特征增强是一种常用的处理特征数据的方法,通过对特征数据进行一系列操作和变换得到更具判别性的特征,以提升模型的特征表达能力。捕获RGB和热力图像中的有效信息是RGB-T显著性目标检测的一个关键问题,也是基于特征增强的方法主要解决的问题。Zhang等人[18]最先意识到了该问题,提出了一个近层特征融合(Fusing Multi-level CNN Features,FMCF)的方法,它将每个模态的中间三层特征分别与各自的相邻层特征聚合,探索了多层次特征的互补性。Zhang等人[19]通过级联不同膨胀率的空洞卷积层和最大池化层设计了一个混合空洞池化模块,探索了多尺度下特征的上下文信息,在丰富了特征尺度的同时,增强了全局和局部特征的空间一致性。Bi等人[20]设计了一个并行对称融合模块,以并行对称的方式整合相邻层的关键显著性线索进行显著性预测。Tu[21]引入了基于卷积的注意力模块,该模块级联了通道注意力和空间注意力,能够过滤掉特征中不重要的信息。Tu[22]等人和Wang等人[23]挖掘网络最深层语义信息来引导浅层特征获取更加有效的特征表示。

图 3展示了经典的RGB-D SOD方法RD3D(RGB-D SOD via 3D CNN)[24]和早期具有代表性的RGB-T SOD方法MIDD(Multi-Interactive Dual-Decoder)[22]在低质量RGB图像(第1行)、低质量热红外图像(第2行)、高质量RGB-T图像(第3行)和复杂背景(第4、5行)下的结果。从图中可以看出,RGB和热红外图像的成像质量会受各种因素(如温度、光照等)的影响,不加以区分地使用它们会导致网络受到严重的噪声干扰。此外,RGB和热成像两种模态信息是从不同角度表达画面的特征,是同一张图像的不同属性,在特征表示层面存在差异,不当地处理差异信息也同样会引入噪声。因此,一些方法考虑如何有效地探索多模态特征之间一致性与差异性来补充或过滤低质量的单模态信息。Chen等人[25]设计了一个特征差异缩减模块,通过捕获的差异性信息增强双模态特征的一致性。Liao等人[26]提出一个交叉协同增强策略,自适应地从每个模态中收集更有效的特征表示,并协同纠正有缺陷的特征响应。与上述方法不同,Cong等人[27]认为低光场景下的RGB图像质量不佳,因此引入了光照度评分的方法评估图像质量,避免了低质量的输入。

3)基于特征融合的方法。作为多模态视觉任务,如何有效地融合多模态特征是RGB-T显著性目标检测的另一个关键问题,基于特征融合的方法旨在充分挖掘两种模态间的互补属性并充分利用它们各自的优势。一些方法直接地融合多模态特征[17-18],但这种方式容易受到噪声信息和冗余数据的限制。现有的方法主要考虑如何自适应地、有选择地融合两个模态的特征,例如:Liang等人[28]提出了一个多模态交互注意单元,它可以学习内容相关的权重向量自适应地融合重要的多模态信息。Chen等人[25]设计了一个基于注意力的交叉注意融合模块,分别在通道和空间层面融合更加重要的特征。Gao等人[29]受到视觉色相学说中视觉颜色感知的有效选择和对抗过程的启发,设计了多阶段的特征融合方法MMNet(Multi-stage and Multi-scale fusion Network)。该方法将有效特征的捕获和融合对应上述两个过程,可以有效地增强显著区域并抑制多模态的不一致性和低质量数据的影响。Pang等人[30]组合自注意力和交叉注意力提出了一个跨模态聚合单元,根据语义相似性从全局序列中的其他特征收集信息,并为两种注意力计算增加了通道分支,充分利用空间和通道视角下的模态间和模态内信息。此外,考虑到两种注意力的计算复杂度,他们还设计了一个无参数逐像素的补丁嵌入来降低运算开销。

总的来说,从上述方法我们可知上下文语义、模态差异等信息对RGB-T显著性目标检测任务至关重要,而注意力机制能有效减少噪声干扰,特别是自注意力能够建立全局上下文信息,能够在一定程度上克服CNN不擅长捕获全局特征的问题。除此之外,还有一些方法考虑到边缘设备有限的计算资源,设计了轻量化的RGB-T显著性目标检测方法[31-32]。尽管基于CNN的RGB-T显著性目标检测方法受到了广泛的关注,由于CNN本身存在更关注局部特征,对位置信息不敏感,这些方法在面对一些需要感知全局语义的场景仍然存在不足,还需要进一步的探索和研究。

1.2.2 基于ViT的RGB-T显著性目标检测

得益于强大的全局特征建模能力,ViT克服了CNN关注局部信息的局限性,在其被引入计算机视觉领域后,基于ViT的方法在多个任务中拥有优异的表现[33-34]。ViT将输入图像转化为一个序列,并为其添加位置编码以保证处理过程中的序列关系。自注意力机制是ViT的核心组件,通过学习,它可以为输入建立Q(query)、K(key)和V(value)3种映射表示,从而计算序列中每个位置的相关性。通过调整Q、K、V的使用,ViT可以获取全局上下文关系,构建丰富的信息表示。2021年,首个基于ViT的RGB-T显著性目标检测方法SwinNet[35](Swin Transformer drives Network)被提出,显示出此类方法巨大的发展潜力。随后也有一些研究对此类方法进行了探索,但总体上仍处于发展的初级阶段,本节将逐一对现有基于ViT的RGB-T显著性目标检测方法进行介绍。

Liu等人[35]基于Swin-Transformer提出了第一个基于ViT的方法,该方法通过注意力机制增强双模态特征一致性并用边缘信息锐化显著性目标的轮廓。Chen等人[36]认为RGB图像倾向于提供外观和纹理信息,而热力图像以提供几何和空间结构线索为主。受风格迁移的启发,他们提出了一个风格迁移融合模块,在每个层级转换两种图像特征来减少模态的差异性。他们针对融合时高低层特征的平等性问题和空间错位问题设计了一个多尺度通道注意力模块,从全局和局部的角度为多级特征赋权。此外,他们还基于反向注意力来聚合前背景信息,进一步细化目标边界。Tang等人[37]将研究的视角转向不同于前两者的高分辨率网络,提出了HRTransNet。基于在网络全程保持高分辨率特征的HRFormer[38],他们将热力信息视作辅助模态,通过注意力机制有权重地将其注入到RGB模态中,在输入层面上实现特征的融合。此外,他们还利用自注意力和交叉注意力在输出层面上探索了多级特征的互补性。

相较于CNN的方法,此类方法在检测完整性上更具优势,这得益于ViT捕获远程依赖的能力。但ViT将图像分块的操作会导致细节信息丢失,产生块效应(Block Artifact)乃至出现大面积误检区域。事实上,全局信息和局部信息对计算机视觉任务都非常重要,尽管会引入额外的计算,但是利用CNN的结构获取局部信息的能力弥补ViT的缺陷是一个值得研究的方向。

2. 数据集和评价指标

2.1 RGB-T显著性目标检测数据集

受到设备限制,热红外数据获取困难,早期的研究提出了一些小规模数据集[8],但没有被普及使用。Wang等人提出了第一个RGB-T显著性目标检测的基准VT821[7]。自此以后,RGB-T显著性目标检测的方法使用的数据集主要以VT821为主,部分方法还会加入单独的热红外图和RGB图像来扩大训练数据[19]。Tu带领他的团队,先后又提出了VT1000[15]和VT5000[21],RGB-T显著性目标检测的数据集得到了极大的扩充,VT821、VT1000和VT5000也成为目前最常用的RGB-T显著性目标检测任务的数据集。表 1简要汇总了这3个数据集的相关信息。

表 1 RGB-T显著性目标检测数据集Table 1. The RGB-T salient object detection datasetsName Year Scales Camera equipment Disadvantage VT821 2018 821 FLIR A310、SONY TD-2073 1. Simple scenes that lack complexity and variety.

2. The camera uses different parameters when capturing RGB and thermal images.

3. Additional whitespace is introduced when aligning images.VT1000 2019 1000 FLIR SC620 1. There are potential errors as the images are aligned manually.

2. Limited scenario complexity and diversity.VT5000 2020 5000 FLIR T640、FLIR T610 1. Images are affected by thermal crossover, making detection challenging. 2.2 常用的评价指标

遵循大多数方法,RGB-T显著性目标检测使用PR曲线、F测度和平均绝对值误差(Mean Absolute Error,MAE)作为常用的评价指标。此外,RGB-T显著性目标检测引入了S测度(S-measure)和E测度(E-measure)来进一步提升评价指标的可靠性。

1)S测度(S-measure)[39]。S测度能够评估预测图和真值图之间的结构相似性,并且同时能够评估结构的完整性,S测度定义为:

$$ {S_\lambda } = \lambda \times {S_{\text{O}}} + \left( {1 - \lambda } \right){S_{\text{r}}} $$ (1) 式中:Sr为区域感知度量,用于评估局部结构相似性;SO为对象感知度量,用于解释全局结构相似性,λ为超参数。

2)E测度(E-measure)[40]。E测度是一种模拟人眼判别图片目标的指标,能够捕获自适应的全局和局部相似性,其定义如下:

$$ {E_{{\text{FM}}}} = \frac{1}{{w \times h}}\sum\limits_{x = 1}^w {\sum\limits_{y = 1}^h {{\phi _{{\text{FM}}}}} } \left( {x, y} \right) $$ (2) 式中:h和w分别是图片的高度和宽度;FM在原文中定义为前景图(foreground map),即检测到的目标。

3. 实验分析

本章对近年来部分方法进行了定性和定量比较,旨在更直观地展示RGB-T显著性目标检测发展水平。本章采用了2.2节中介绍的几个常用的评价指标,在VT821、VT1000和VT5000数据集上对具有代表性的RGB-T显著性目标检测方法进行了定量和定性比较。

3.1 基于机器学习的RGB-T显著性检测方法对比

基于机器学习的方法的定量比较结果如表 2所示。通过表中数据可知,尽管此类方法在几个评价指标上的结果有所提升,但仍然处于一个较低的水平,其可视化结果如图 4(第4,5列)所示。从图中可以看出,基于机器学习的方法能够有效地定位出显著性目标区域,但存在大面积的误检、漏检等问题。正如前文所述,由于手工特征的局限性,这类方法只能在一些简单场景产生好的结果(第1行),面对复杂情况效果较差甚至失效(第2~6行)。由此可见,特征的获取对于RGB-T显著性目标检测任务至关重要。

表 2 基于机器学习的RGB-T显著性目标检测方法定量比较Table 2. Quantitative comparison of machine learning-based RGB-T salient object detection methodsAlgorithms VT821 VT1000 VT5000 S↑ F↑ E↑ MAE↓ S↑ F↑ E↑ MAE↓ S↑ F↑ E↑ MAE↓ MTMR[7] 0.725 0.662 0.815 0.108 0.706 0.715 0.836 0.119 0.680 0.595 0.795 0.114 N3S-NIR[10] 0.723 0.734 0.859 0.140 0.726 0.717 0.827 0.145 0.652 0.575 0.780 0.168 LTCR[11] 0.762 0.737 0.854 0.088 0.799 0.794 0.872 0.084 - MGFL[12] 0.782 0.725 0.841 0.071 0.820 0.801 0.882 0.066 0.751 0.661 0.817 0.085 Note: ↑ indicates that the larger the indicator, the better, and ↓ indicates that the smaller the indicator, the better. Bold and underline indicate optimal and sub-optimal results, respectively. 3.2 基于深度学习的方法比较

本文将基于深度学习的RGB-T显著性目标检测方法分为基于CNN的方法和基于ViT的方法两类进行实验对比,表 3展示了基于CNN的方法和基于ViT的方法的定量比较。由表中数据可知,基于ViT的方法在几个数据集的评价指标上大部分都优于基于CNN的方法,这可能得益于ViT通过建立长期依赖捕获的全局特征相较于CNN获取的局部特征包含更多的有效信息。图 4(第6~13列)可视化了部分具有代表性的基于深度学习的方法,包括小目标(第1行)、多目标(第2行)、低光场景(第3行)、低质量热力图像(第4行)、难以区分的前景(第5行)和杂乱场景(第6行)。相比于基于机器学习的方法,基于深度学习的RGB-T显著性目标检测方法显著减少了误检和漏检区域。如图 4所示,在面对多目标时,大部分基于CNN的方法存在漏检的问题,而基于ViT的方法都能有效地定位出所有的显著目标,这也侧面印证了ViT更擅长捕获图像的全局上下文信息。此外,如第3、4行所示,低质量的单模态输入对于简单场景下的基于深度学习的RGB-T显著性目标检测方法影响较小,但是面对更加复杂的情况(第5行),不加以区分地使用双模态特征会显著地影响预测结果(第6、9列)。此外,尽管RGB图像和热力图像都提供了充分的细节,但根据第2行的结果,所有的方法都没有很好地刻画出每个目标镂空部分的轮廓。第5行所展示场景中,大部分方法也同样没有能够定位出完整目标边界。事实上,边界模糊的问题是包括RGB-T显著性目标检测在内的所有像素级预测任务都面临的挑战。随着成像技术的发展,现在获取到的图像分辨率极高,例如清晰度为1080p的图像大约包含200万个像素。目前的视觉任务为了减少网络的计算量,通常会将输入图像调整为合适的大小(如224×224,256×256等),在网络处理完之后通过上采样的方式恢复分辨率,但这种操作会不可逆地丢失一部分信息。为此,现有的方法通常会在解码阶段引入浅层的编码特征来补充细节信息,但这不可避免地引入了噪声。此外,CNN为了减少计算和扩大感受野而交替使用卷积层和池化层,这进一步加剧了不可逆的信息丢失。

表 3 基于深度学习的RGB-T显著性目标检测方法定量比较Table 3. Quantitative comparison of deep learning-based RGB-T salient object detection methodsMethods Algorithms Backbone VT821 VT1000 VT5000 S↑ F↑ E↑ MAE↓ S↑ F↑ E↑ MAE↓ S↑ F↑ E↑ MAE↓ CNN-based FMCF[8] VGG16 0.760 0.640 0.796 0.080 0.873 0.823 0.921 0.037 0.814 0.734 0.864 0.055 SGDL[15] VGG19 0.765 0.730 0.847 0.085 0.787 0.764 0.856 0.090 0.750 0.672 0.824 0.089 ADFNet[21] VGG16 0.810 0.716 0.842 0.077 0.910 0.847 0.921 0.034 0.863 0.778 0.891 0.048 MIDD[22] VGG16 0.871 0.804 0.895 0.045 0.915 0.882 0.933 0.027 0.867 0.801 0.897 0.043 CGFNet[23] VGG16 0.881 0.845 0.912 0.038 0.923 0.906 0.944 0.023 0.883 0.851 0.922 0.035 CGMDRNet[25] Res2Net-50 0.894 0.840 0.920 0.035 0.931 0.893 0.940 0.020 0.896 0.846 0.928 0.032 TNet[27] ResNet-50 0.898 0.841 0.919 0.030 0.928 0.889 0.937 0.021 0.894 0.847 0.927 0.033 MIA_DPD[28] ResNet-50 0.844 - 0.850 0.070 0.924 - 0.926 0.025 0.879 - 0.893 0.040 MMNet[29] ResNet-50 0.875 0.798 0.893 0.040 0.917 0.863 0.924 0.027 0.864 0.785 0.890 0.043 CAVER[30] ResNet-50 0.891 0.839 0.919 0.033 0.935 0.903 0.945 0.018 0.891 0.842 0.930 0.032 CSRNet[31] ESPNet’v2 0.885 0.830 0.908 0.038 0.918 0.877 0.925 0.024 0.868 0.810 0.905 0.042 ViT-based SwinNet[35] Swin transformer 0.904 0.847 0.926 0.030 0.938 0.896 0.947 0.018 0.912 0.865 0.942 0.026 HRTransNet[37] HRFormer 0.906 0.853 0.929 0.026 0.938 0.900 0.945 0.017 0.912 0.871 0.945 0.025 MITF-Net[36] PVT’v2 0.905 0.853 0.927 0.027 0.938 0.906 0.949 0.016 0.910 0.870 0.943 0.025 Note: ↑ indicates that the larger the indicator, the better, and ↓ indicates that the smaller the indicator, the better. Bold and underline indicate optimal and sub-optimal results, respectively. 除上述问题外,目前RGB-T显著性目标检测还面临着以下挑战:①低质量的RGB图像和低质量的热红外图。如图 5所示,在低光环境下(第1行)RGB图像无法提供足够的颜色、纹理等信息,而低质量的热力图又存在大量干扰信息,现有的方法无法准确地定位显著性目标。②数据集误差。现有的RGB-T显著性目标检测数据集中存在着未对齐的掩膜(第2行)和有歧义的注释(第3~4行)等问题,这会误导模型使其无法得到正确的预测结果。

4. 结语

本文整理了现有的RGB-T显著性目标检测方法,分为机器学习的方法和基于深度学习的方法两大类进行总结,并从结构的角度着重分析了基于深度学习的方法。此外,本文还归纳了RGB-T显著性目标检测常用的数据集和具有代表性的评价指标,并在其之上对现有的方法进行实验分析。与机器学习的方法相比,基于深度学习的方法能够从大量的数据中提取不同的富含丰富信息的特征,具有更强的泛化能力,更善于应对不同的复杂场景。但该领域仍然面临着一些诸如边界模糊、低质量输入等方面的挑战,对于双模态特征互补性、边界信息的探索仍然值得继续深挖。对于RGB-T显著性目标检测任务的未来发展,可从以下两方面考虑:

1)数据集:如前文所述,现有的RGB-T显著性目标检测常用的数据集仍然存在一些问题。这可能和数据采集方式、标注显著性目标的主观性等方面有关。此外,诸如显著性目标检测、显著性实例分割等相近领域拥有数量更多、规模更大、场景更加多样的数据集[41-42],能够为训练模型的泛化能力提供数据上的支持。目前RGB-T显著性目标检测3个常用的数据集中,有且仅有一个规模相对较大的数据集VT5000。而数据的数量和质量能够明显地影响模型的好坏,更加准确有效的大规模数据集对RGB-T显著性目标检测具有重要的研究意义。

2)监督方式:目前的RGB-T显著性目标检测模型大多基于像素级全监督信息,但在实际场景中,大规模、高质量的像素级标注的成本是巨大的。因此,探究在少量甚至无标注数据下的RGB-T显著性目标检测方法是非常有价值的,比如弱监督/半监督/自监督等方法的研究。近期,Liu等人[14]基于涂鸦提出了第一个弱监督的RGB-T显著性目标检测方法,为该方向接下来的发展提供了借鉴。

-

表 2 管道单一漏点图像不同算法评价指标结果

Table 2 Different algorithms evaluate the index results of the pipeline single leakage point images

Algorithms 40℃ image 50℃ image 60℃ image PSNR/dB SSIM PSNR/dB SSIM PSNR/dB SSIM Mean filtering 33.1973 0.6361 32.0505 0.7035 31.8188 0.7090 Median filtering 31.7137 0.4941 31.8480 0.6074 31.8348 0.6098 Nonlinear smooth wavelet 30.6688 0.5267 30.1091 0.5329 30.0417 0.5449 Bilateral filtering 34.4566 0.7285 33.5595 0.8230 33.4039 0.8399 Nonlinear smooth wavelet + Bilateral filtering 36.9294 0.8747 34.6604 0.8631 33.9055 0.8647 表 3 管道多泄漏图像不同算法评价指标结果

Table 3 Different algorithms evaluate the index results of the pipeline multi-leakage images

Algorithms 40℃ image 50℃ image 60℃ image PSNR/dB SSIM PSNR/dB SSIM PSNR/dB SSIM Mean filtering 32.6347 0.7257 32.5378 0.7233 31.7827 0.7395 Median filtering 31.724 0.6547 31.7715 0.6338 31.6588 0.6362 Nonlinear smooth wavelet 30.3137 0.5603 30.2969 0.5515 29.9108 0.5786 Bilateral filtering 32.5065 0.8041 32.5169 0.8047 32.4259 0.8335 Nonlinear smooth wavelet + Bilateral filtering 36.6188 0.8883 36.5284 0.8921 34.5147 0.8900 表 4 四种算法对管道单一漏点的性能测试结果

Table 4 Performance test results of four algorithms on single leak points of pipelines

Model Train time/s mAP Precision/% Detection time/(s/f) YOLO v4 2764.5149 0.9822 98.3 0.3021 YOLO v3 4372.9816 0.9700 98.2 0.3681 SSD 300 2778.0019 0.9800 96.6 0.8946 Faster

R-CNN40383.878 0.8000 69.1 1.7956 表 5 四种算法对管道多泄漏点的性能测试结果

Table 5 Performance test results of four algorithms on multiple leak points of pipelines

Model Train time/s mAP Precision/% Detection time/(s/f) YOLO v4 2074.8823 0.98 98.36 0.3096 YOLO v3 3460.6947 0.97 92.80 0.4733 SSD 300 1642.4262 0.91 98.30 0.9182 Faster

R-CNN23405.0819 0.88 54.80 1.8671 -

[1] Adegbove M A, Fung W K, Karnik A. Recent advances in pipeline monitoring and oil leakage detection technologies: principles and approaches[J]. Sensors, 2019, 19(11): 2548. DOI: 10.3390/s19112548

[2] ZHOU S J, LIU C, ZHAO Y E, et al. Leakage diagnosis of heating pipe-network based on BP neural network[J]. Sustainable Energy, Grids and Networks, 2022, 32: 100869. DOI: 10.1016/j.segan.2022.100869

[3] 孙宗康, 饶睦敏, 曹裕灵, 等. 基于小样本不均衡数据的供水管道泄漏智能检测算法[J]. 图学学报, 2022, 43(5): 825-831. https://www.cnki.com.cn/Article/CJFDTOTAL-GCTX202205008.htm SUN Z K, RAO M M, CAO Y L, et al. Water supply pipeline leakage intelligent detection algorithm based on small and unbalanced data [J]. Journal of Graphics, 2022, 43(5): 825-831. https://www.cnki.com.cn/Article/CJFDTOTAL-GCTX202205008.htm

[4] 石光辉, 齐卫雪, 陈鹏, 等. 负压波与小波分析定位供热管道泄漏[J]. 振动与冲击, 2021, 40(14): 212-218. https://www.cnki.com.cn/Article/CJFDTOTAL-ZDCJ202114028.htm SHI G H, QI W X, CHEN P, et al. Negative pressure wave and wavelet analysis to locate the heating pipeline leakage[J]. Journal of Vibration and Impact, 2021, 40(14): 212-218. https://www.cnki.com.cn/Article/CJFDTOTAL-ZDCJ202114028.htm

[5] 薛田甜, 刘永莉, 陈智, 等. 基于分布式光纤测温技术的管廊管道泄漏检测设计[J]. 中国科技论文, 2023, 18(8): 867-874, 889. DOI: 10.3969/j.issn.2095-2783.2023.08.008 XUE T T, LIU Y L, CHEN Z, et al. Design of pipeline leakage detection based on distributed temperature sensing technology[J]. China Science Paper, 2023, 18(8): 867-874, 889. DOI: 10.3969/j.issn.2095-2783.2023.08.008

[6] 高琳, 曹建国. 基于输气管道泄漏声发射信号特征的小波基构造研究[J]. 振动与冲击, 2023, 42(10): 128-135. https://www.cnki.com.cn/Article/CJFDTOTAL-ZDCJ202310016.htm GAO L, CAO J G. Research on wavelet basis construction based on the characteristics of acoustic emission signals in gas pipe leakage [J]. Journal of Vibration and Impact, 2023, 42(10): 128-135. https://www.cnki.com.cn/Article/CJFDTOTAL-ZDCJ202310016.htm

[7] 徐志远, 肖奇. 基于脉冲远场涡流的管道缺陷外检测与定量评估[J]. 电子测量与仪器学报, 2019, 33(2): 80-87. https://www.cnki.com.cn/Article/CJFDTOTAL-DZIY201902011.htm XU Z Y, XIAO Q. Outside inspection and quantitative evaluation of pipe defects based on pulsed remote field eddy currents[J]. Journal of Electronic Measurement and Instrumentation, 2019, 33(2): 80-87. https://www.cnki.com.cn/Article/CJFDTOTAL-DZIY201902011.htm

[8] 李甲振, 余弘婧, 郭新蕾, 等. 管道系统泄漏的可控低强度瞬变流检测法[J]. 应用基础与工程科学学报, 2022, 30(4): 873-882. https://www.cnki.com.cn/Article/CJFDTOTAL-YJGX202204007.htm LI J Z, YU H J, GUO X L, et al. Leak detection in pipe using controllable and low-pressure transient analysis method[J]. Journal of Basic Science and Engineering, 2022, 30(4): 873-882. https://www.cnki.com.cn/Article/CJFDTOTAL-YJGX202204007.htm

[9] Fahimipirehgalin M, Trunzer E, Odenweller M, et al. Automatic visual leakage detection and localization from pipelines in chemical process plants using machine vision techniques[J]. Engineering, 2021, 7(6): 758-776. DOI: 10.1016/j.eng.2020.08.026

[10] 张丽珍, 徐长航, 陈国明. 基于红外成像技术的高温管道泄漏检测研究[C]//第二届CCPS中国过程安全会议, 2014: 389-394. ZHANG L Z, XU C H, CHEN G M. The detection of high-temperature pipe leakage by infrared thermography[C]//Proceedings of the 2nd CCPS China Process Safety Conference, 2014: 389-394.

[11] 张艳博, 任瑞峰, 梁鹏, 等. 基于热成像的埋地热力管道缺陷检测试验研究[J]. 仪器仪表学报, 2020, 41(6): 161-170. https://www.cnki.com.cn/Article/CJFDTOTAL-YQXB202006019.htm ZHANG Y B, REN R F, LIANG P, et al. Experimental study on flaw detection of buried heat pipeline based by infrared thermal[J]. Chinese Journal of Scientific Instrument, 2020, 41(6): 161-170. https://www.cnki.com.cn/Article/CJFDTOTAL-YQXB202006019.htm

[12] Yahia M, Gawai R, Ali T, et al. Non-destructive water leak detection using multitemporal infrared thermography[J]. IEEE Access, 2021, 9: 72556-72567. DOI: 10.1109/ACCESS.2021.3078415

[13] XIE J, ZHANG Y, HE Z, et al. Automated leakage detection method of pipeline networks under complicated backgrounds by combining infrared thermography and Faster R-CNN technique[J]. Process Safety and Environmental Protection, 2023, 174: 39-52. DOI: 10.1016/j.psep.2023.04.006

[14] ZHOU R L, WEN Z P, SU H Z. Detect submerged piping in river embankment by passive infrared thermography[J]. Measurement, 2022, 202: 111873. DOI: 10.1016/j.measurement.2022.111873

[15] 翟潘, 王平. 自适应维纳滤波在钢水红外图像去噪中的应用[J]. 红外技术, 2021, 43(7): 665-669. http://hwjs.nvir.cn/cn/article/id/0a8e3190-fcd2-405b-9b8f-0cd65fb70cd5 ZHAI P, WANG P. Application of the adaptive wiener filter in infrared image denoising for molten steel [J]. Infrared Technology, 2021, 43(7): 665-669. http://hwjs.nvir.cn/cn/article/id/0a8e3190-fcd2-405b-9b8f-0cd65fb70cd5

[16] 郭晨龙, 赵旭阳, 郑海燕, 等. 一种基于改进非局部均值滤波算法的红外图像去噪[J]. 红外技术, 2018, 40(7): 638-641. http://hwjs.nvir.cn/cn/article/id/hwjs201807003 GUO C L, ZHAO X Y, ZHENG H Y, et al. Infrared image denoising method based on improved non-local means filter[J]. Infrared Technology, 2018, 40(7): 638-641. http://hwjs.nvir.cn/cn/article/id/hwjs201807003

[17] ZHAO X H, LI M X, NIE T, et al. An innovative approach for removing stripe noise in infrared images[J]. Sensors, 2023, 23: 6786. DOI: 10.3390/s23156786

[18] ZHANG X, SANIIE J, BAKHTIARI S, et al. Unsupervised learning for detection of defects in pulsed infrared thermography of metals[C]// IEEE International Conference on Electro Information Technology (EIT), 2022: 330-334.

[19] ZHANG X, SANIIE J, BAKHTIARI S, et al. Compression of pulsed infrared thermography data with unsupervised learning for nondestructive evaluation of additively manufactured metals[J]. IEEE Access, 2022, 10: 9094-9107. DOI: 10.1109/ACCESS.2022.3141654

[20] WANG H, HOU Y, HE Y, et al. A physical-constrained decomposition method of infrared thermography: pseudo restored heat flux approach based on ensemble bayesian variance tensor fraction[J]. IEEE Transactions on Industrial Informatics, 2023, 20(3): 3413-3424.

[21] Kumar A, Tomar H, Mehla Kumar V, et al, Stationary wavelet transform based ECG signal denoising method[J]. ISA Transactions, 2021, 114: 251-262. https://www.cnki.com.cn/Article/CJFDTOTAL-NYJX202403024.htm [22] Kumar S, Alam K, Chauhan A. Fractional derivative based nonlinear diffusion model for image denoising[J]. SeMA Journal, 2022, 79: 355-364. DOI: 10.1007/s40324-021-00255-0

[23] 王玉灵. 基于双边滤波的图像处理算法研究[D]. 西安: 西安电子科技大学, 2010. WANG Y L. Study of algorithm in image processing based on the bilateral filter[D]. Xi'an: XiDian University, 2010.

[24] Bochkovskiy A, WANG C Y, LIAO H Y M. Yolov4: Optimal speed and accuracy of object detection[C]//IEEE Conference Computer Vision and Pattern Recognition, 2020: 10934-10951.

[25] 中华人民共和国住房和城乡建设部. 建筑给水排水设计标准GB50015-2019[S]. 北京: 中国计划出版社, 2019. Ministry of Housing and Urban-Rural Development of the People's Republic of China. Standard for design of building water supply and drainage[S]. Beijing: China Planning Press, 2019.

[26] LIU R C, LI Y F, WANG H D, et al. A noisy multi-objective optimization algorithm based on mean and Wiener filters[J]. Knowledge-Based Systems, 2021, 228: 107215. DOI: 10.1016/j.knosys.2021.107215

[27] Verma, K, Singh K B, Thoke A. S. An enhancement in adaptive median filter for edge preservation[J]. Procedia Computer Science, 2015, 48: 29-36. DOI: 10.1016/j.procs.2015.04.106

[28] 魏明强, 冯一箪, 王伟明, 等. 基于区间梯度的联合双边滤波图像纹理去除方法[J]. 计算机科学, 2018, 45(3): 31-36. https://www.cnki.com.cn/Article/CJFDTOTAL-JSJA201803005.htm WEI M Q, FENG Y D, WANG W M, et al. Interval gradient based joint bilateral filtering for image texture removal[J]. Computer Science, 2018, 45(3): 31-36. https://www.cnki.com.cn/Article/CJFDTOTAL-JSJA201803005.htm

[29] REN S, HE K, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149. DOI: 10.1109/TPAMI.2016.2577031

[30] LIU W, Anguelov D, Erhan D, et al. SSD: single shot multi-box detector[C]//Proceedings of the IEEE European Conference on Computer Vision, 2016: 21-37.

[31] Redmon J, Farhad A. Yolov3: an incremental improvement[C]// Computer Vision and Pattern Recognition, 2018: 1068-1076.

-

期刊类型引用(3)

1. 赵梓渊,唐意东,黄树彩. 基于张量分解的光谱图像压缩感知重构. 现代防御技术. 2024(01): 92-101 .  百度学术

百度学术

2. 关禹聪,胡源,刘子龙,周新雨. 小F数红外光学系统设计. 红外技术. 2024(12): 1433-1439 .  本站查看

本站查看

3. 闫晶,沈娴,王政. 嵌入式技术的偏振光谱成像系统设计. 激光杂志. 2023(09): 248-253 .  百度学术

百度学术

其他类型引用(3)

下载:

下载: