Infrared and Visible Image Fusion Based on Multi-scale and Attention Model

-

摘要: 针对红外与可见光图像在融合后容易出现伪影,小目标轮廓不清晰等问题,提出一种基于多尺度特征与注意力模型相结合的红外与可见光图像融合算法。通过5次下采样提取源图像不同尺度的特征图,再将同一尺度的红外与可见光特征图输入到基于注意力模型的融合层,获得增强的融合特征图。最后把小尺度的融合特征图进行5次上采样,再与上采样后同一尺度的特征图相加,直到与源图像尺度一致,实现对特征图的多尺度融合。实验对比不同融合框架下融合图像的熵、标准差、互信息量、边缘保持度、小波特征互信息、视觉信息保真度以及融合效率,本文方法在多数指标上优于对比算法,且融合图像目标细节明显轮廓清晰。Abstract: Aiming at the problems that infrared and visible images are prone to artifacts and unclear outlines of small targets after fusion, an infrared and visible images fusion algorithm based on the combination of multi-scale features and attention model is proposed. The feature maps of different scales of the source image are extracted through five times of down-sampling, and then the infrared and visible image feature maps of the same scale are input to the fusion layer based on the attention model to obtain an enhanced fusion feature map. Finally, the small-scale fusion feature map is up-sampled five times, and then added to the feature map of the same scale after up-sampling, until the scale is consistent with the source image, and the multi-scale fusion of the feature map is realized. Experiments compare the entropy, standard deviation, mutual information, edge retention, wavelet feature mutual information, visual information fidelity, and fusion efficiency of fused images under different fusion frameworks. The method in this paper is superior to the comparison algorithm in most indicators, and the target details are obvious and the outline are clear in the fused images.

-

Keywords:

- image fusion /

- multi-scale feature fusion /

- attention model /

- infrared images

-

0. 引言

对多模态图像进行融合从而得到更全面的描述信息是国内外图像研究与应用关注的重点方向[1]。进行融合的源图像主要来自于视觉传感器,在光照条件良好的情况下,使用普通视觉传感器,当光照不足时就需要用到红外相机[2]。红外图像的抗干扰能力强,能够弥补可见光图像的缺点,但是红外图像的分辨率低和纹理细节模糊[3-4]。所以,考虑将红外图像与可见光图像进行融合,获得更加完整的场景信息。

目前,国内外已提出较多的图像融合算法,如陈潮起[5]等人提出了一种基于多尺度低秩分解的图像融合方法,通过多尺度低秩分解将红外与可见光图像分别分解为显著图和细节图,根据分解图像的特点,有针对地设计最优融合策略,通过此算法生成的融合图像目标清晰、细节丰富。林子慧[6]等人将显著性检测算法进行改进,得到一种能够提取红外图像显著图的算法,利用此算法指导高低频分解图像的融合策略,得到的融合图像有较好的视觉效果。但是,传统方法的数据量多,且往往根据图像的单一特征进行图像融合,导致融合图像信息量不多。随着神经网络在图像处理领域的发展,由于神经网络的计算能力强大,基于深度学习的图像融合算法被提出来,利用神经网络对源图像进行特征提取能够弥补传统图像融合方法的缺陷。马旗[7]等人提出了基于VGG(visual geometry group)网络的双波段图像融合方法,将源图像输入VGG模型提取特征图,通过ZCA(zero-phase component analysis)白化加归一化处理将特征降为二维,再通过3次插值将特征恢复为源图像的尺寸,最后加权平均得到融合图。该方法的融合速度明显高于其他方法。Li[8]等人提出基于Resnet和零相位分量分析的图像融合方法,首先用Resnet50将源图像的特征提取出来,然后将提取到的样式特征和内容特征用零相位分析投影到同一空间,再通过零相位的反向操作得到最终的转换特征,最后通过解码网络获得融合图像,该方法在主客观评价上均具有较好融合性能。

基于深度学习的图像融合框架包括编码网络、融合层以及解码网络3部分。在编码网络采用卷积神经网络提取源图像的特征;在融合层将提取到的特征图进行融合,获得融合的特征图;在解码网络将融合的特征图恢复为源图像大小。此框架有利于源图像特征的提取以及融合图像的生成,基于此框架,本文提出一种基于多尺度特征的图像融合框架(feature pyramid network fuse, FPNFuse),更好地提取源图像的特征以及融合多尺度特征。同时采用两阶段注意力模型的融合策略,突出融合图像的目标。

1. 算法思想

本文通过编码网络提取红外与可见光源图像不同尺度的特征图,将两阶段注意力模型加入融合层,融合提取的特征图。在解码网络将融合层输出的多尺度特征图进一步融合,解码融合的特征图,得到最终的融合图像。

1.1 多尺度特征融合框架FPNFuse

采用深度学习框架进行图像融合,传统的方法是直接使用训练好的VGG[7]或者Resnet[8]深度卷积网络进行特征提取。这些网络的卷积层数多,且随着卷积层数的增加,特征图的空间分辨率减少,尺寸减小,高级语义特征被提取出来。但是只使用最后一层的深度特征进行图像融合,可能使小目标完全丢失,不利于图像中小目标的融合。因此借鉴特征金字塔结构[9],提出多尺度特征图像融合框架FPNFuse,进行图像特征的提取与多尺度特征的融合。

在编码网络通过不同倍数的下采样获得不同尺寸的特征图,在解码网络将不同尺寸的特征图融合在一起。尺寸大的特征图分辨率高,能够保留小目标的特征,尺寸小的特征图有较高语义信息,能够提取深度的特征信息,将多尺度特征图融合起来就能兼具这两种优点。

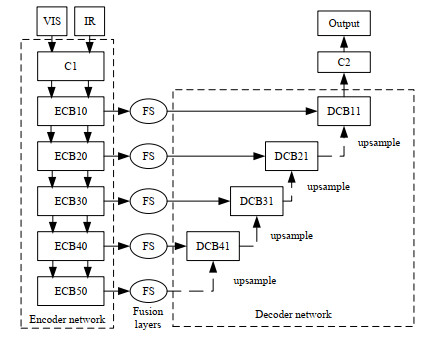

多尺度融合框架FPNFuse如图 1所示,在编码网络,将红外与可见光图像分别进行2倍下采样、4倍下采样、8倍下采样以及16倍下采样,提取到5种不同尺度的特征图。将每个尺度的红外与可见光特征图输入融合层进行融合,得到不同尺寸的融合特征图,使得源图像不同尺度的特征信息能够被提取出来。在解码层,将不同尺度的融合特征图进行相应倍数的上采样,然后与该尺度的融合特征图进行连接,使多尺度的融合特征图进一步被融合。最后,解码得到与源图像尺寸相同的融合图像。图中C1表示步长为1卷积核为3×3的卷积操作,ECB10-ECB50表示4个下采样层组成的编码网络,FS代表融合策略,DCB41-DCB11表示4个上采样层组成的解码网络。

1.2 基于两阶段注意力模型的融合层

人眼在观察物体时容易被目标区域所吸引,这种现象被称为注意力机制。通过此原理得到的注意力模型通常作为一个单独的模块被加入卷积神经网络结构[10]用于目标检测,其使用可以提高目标检测的准确度。深度神经网络提取的特征图众多,为了更好地利用这些深度特征图,使目标在融合图像中更突出,并且融合图像更适合于人类视觉。因此,将注意力模型引入融合层[11]。目前融合层的融合策略主要是加权平均以及基于L1范数,这两种策略几乎没有对将要融合的特征图进行筛选,融合图像容易引入噪声造成伪影,在融合层引入注意力模型能够尽量少地引入噪声。现今融合层添加的主要是空间注意力模型,但是卷积神经网络提取的特征是三维张量,对于特征图的通道信息也应该进行筛选。所以,将通道注意力模型和空间注意力模型结合起来共同对深度特征进行融合。

红外与可见光图像经过编码网络分别得到5种尺度的特征图,将两类图像相同尺度的特征图同时输入融合层,得到融合两种图像特征的空间增强特征图与通道增强特征图,最后将两种增强特征图进行加权平均获得最终的融合特征图。这个过程见下式(1):

$$ \mathit{\Phi}_{\mathrm{f}}^m=\left[\mathit{\tilde{\Phi}}_{\mathrm{f}}^m(x, y)+\mathit{\overset\frown{\Phi}}_{\mathrm{f}}^m(n)\right] \times \gamma $$ (1) 式中:m表示提取的深度特征级数,文中m=5;Φfm表示每个尺度融合层输出的特征图;γ=0.5表示进行相加的空间注意力与通道注意力的特征权重相等;$\mathit{\tilde{\Phi}}_{\mathrm{f}}^m(x, y) $表示空间注意力模型得到的红外与可见光融合特征图;$\mathit{\overset\frown{\Phi}}_{\mathrm{f}}^m(n) $表示通道注意力模型得到的红外与可见光融合特征图。

1.2.1 空间注意力模型

将源图像的特征图输入到融合层,利用L1-norm计算特征图对应通道数维度向量的各元素之和,再根据软最大算子(soft-max)计算该尺度下深层特征的权重映射,将该权重与未经处理的特征向量相乘得到增强特征,最后红外和可见光图像的增强特征图相加得到空间融合特征图。其过程见下式(2):

$$ \mathit{\tilde{\Phi}}_{\mathrm{f}}^m(x, y)=\sum\limits_{i=1}^K\left(\frac{\left\|\varphi_K^m(x, y)\right\|_1}{\sum\limits_{i=1}^K\left\|\varphi_i^m(x, y)\right\|_1} \times \varphi_K^m(x, y)\right) $$ (2) 式中:k=2,表示进行融合的红外与可见光图像;φKm(x, y)表示通道数维度的特征向量;(x, y)表示其对应的位置;$ \|\cdot\|_1$表示对特征向量进行L1正则化运算;$\mathit{\tilde{\Phi}}_{\mathrm{f}}^m(x, y) $表示利用空间注意力模型在同一尺度下融合两类图像得到的增强特征图。

1.2.2 通道注意力模型

通道注意力模型的计算方式是使用全局池化计算初始加权向量,然后利用软最大算子(soft-max)计算初始加权向量的三维加权向量,最后将三维加权向量与各通道提取到的深度特征向量相乘得到增强特征,将红外和可见光图像的增强特征图相加得到通道融合特征图。其过程见下式(3):

$$\mathit{\overset\frown{\Phi}}_{\mathrm{f}}^m(n)=\sum\limits_{i=1}^K\left(\frac{P\left(\varphi_K^m(n)\right)}{\sum_{i=1}^K P\left(\varphi_i^m(n)\right)} \times \varphi_K^m(n)\right) $$ (3) 式中:P()表示全局池化运算;K=2,表示进行融合的红外与可见光图像;n表示深度特征ϕKm(n)的通道索引。

2. 实验结果分析

2.1 图像质量评价指标

融合图像的质量评价分为主观和客观两种方式,目前,图像融合的客观评价标准分为基于熵、互信息、边缘信息保持度、自然场景分析等[12]。本文选择熵(entropy, EN)、互信息(mutual information, MI)、标准差(standard deviation, SD)、小波特征互信息(feature mutual information based on wavelet, FMI_w、边缘保持度(Qab/f)和视觉信息保真度(visual information fidelity, VIF)等作为融合图像质量评价度量。En越大,表示融合图像包含的信息越多。MI越大,表示融合图像的信息越真实。SD和FMI_w越大,表示融合图像的有效信息越多。Qab/f越大,表示融合到结果图像的边缘信息越多。VIF越大,表示越符合人眼视觉。除此之外,增加融合图像的平均用时(average time, AT)作为融合速率评价指标,平均用时越短表示融合效率越高。

2.2 实验设置

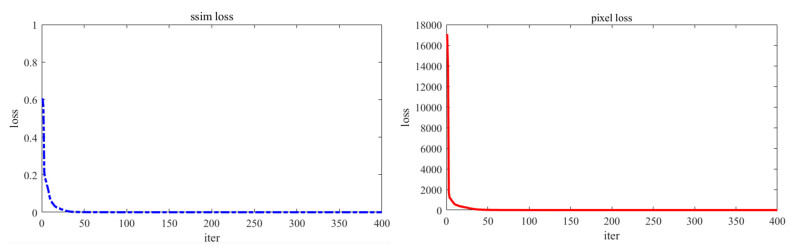

首先训练FPNFuse图像融合框架,实验中学习率设置为lr=1×10-4,批处理大小batch_size=4,epoch=2,使用256×256的红外与可见光图像进行测试。模型的损失为像素损失与结构相似性损失的加权和,结构相似性损失由结构相似性的值乘以权值λ。经过试验对比λ分别为1, 10, 100, 1000,当λ=100时,模型的损失函数收敛的最快,于是在后续试验均基于λ等于100。将此模型与已有的经典图像融合模型作对比,验证所提图像融合算法和两阶段注意力模型的效果。

FPNFuse框架的编码器网络与解码器网络每层的卷积核、步长、输入输出通道数如表 1所示,除池化层以外,编解码网络的激活函数均使用ReLu,步长均为1。解码网络的最后一个卷积层将融合特征图恢复为一张图像,因此将卷积核设置为1×1,最终的输出通道数为1。

表 1 编码网络和解码网络的设置Table 1. The setting of encoder and decoder networksLayer Size Stride Channel(input) Channel(output) Encoder C1 3 1 1 16 ECB10 - - 16 64 ECB20 - - 64 112 ECB30 - - 112 160 ECB40 - - 160 208 ECB50 - - 208 256 Decoder DCB41 - - 464 208 DCB31 - - 368 160 DCB21 - - 272 112 DCB11 - - 176 64 C2 1 1 64 1 ECB Conv 3 1 Nin 16 Conv 1 1 16 Nout max-pooling - - - - DCB conv 3 1 Nin 16 conv 1 1 16 Nout 由于配准好的红外与可见光图像数据集很少,同时训练阶段主要训练模型提取特征的能力,图像类型对模型提取图像特征的能力影响较小。所以使用Microsoft COCO数据集[13]作为训练样本,从中选择80000张图片作为训练集,直到损失函数达到收敛结束训练。每50次记录一下损失值,选择前400次迭代画出损失曲线如图 2所示,从图中可以看出在50次迭代后图像融合模型开始收敛。

2.3 注意力模型对融合性能的影响

为了验证注意力模型对图像融合的影响,使用TNO[14]红外与可见光图像数据集,随机选取23组配准的红外与可见光图片作为测试集。使用FPNFuse和DenseFuse[15]图像融合框架进行实验,改变模型的融合策略,融合策略包括加权平均(add),以及添加了两阶段注意力模型的融合策略,其中通道注意力模型的全局池化函数选择平均池化(avg)。

每个评价度量的平均值如表 2所示,在FPNFuse和DenseFuse模型中添加注意力模块的图像融合模型在熵、标准差、互信息量、边缘保持度、小波特征互信息量以及视觉保真度等指标均优于直接加权平均策略。

表 2 不同融合策略下融合图像质量评价均值Table 2. The mean value of image quality evalution under different fusion strategiesMethod EN SD MI Qab/f FMI_w VIF DenseFuse add 6.8558 35.6741 13.7116 0.3987 0.3567 0.6756 ours 7.0173 42.5361 14.0346 0.4361 0.3651 0.8019 FPNFuse add 6.8312 36.6245 13.6625 0.463 0.4184 0.6818 ours 7.0672 44.5546 14.13447 0.5181 0.4394 0.8263 2.4 不同图像融合框架对比实验结果

将FPNFuse与DeepFuse[16]、WLS[17]、Dense Fuse[15]等图像融合框架进行对比实验。DenseFuse图像融合框架的融合层选择加权平均(DenseFuse_add),以及添加两阶段注意力模型的融合策略,其中通道注意力模型的全局池化函数选择平均池化(avg)。FPNFuse图像融合框架的融合层添加两阶段注意力模型,其中通道注意力模型的全局池化函数选择平均池化(avg)、最大池化(max)和核函数(nuclear)。使用23组测试图像在7个质量评价标准上进行对比,每个评价度量的平均值如表 3所示,这7个指标的最佳值均在FPNFuse_avg和FPNFuse_nu-clear中产生,最佳值在表中加粗。客观评价指标表明所提出的FPNFuse框架能够使融合图像保留更多源图像的边缘信息,且融合效率更高,更适合人类的视觉系统。

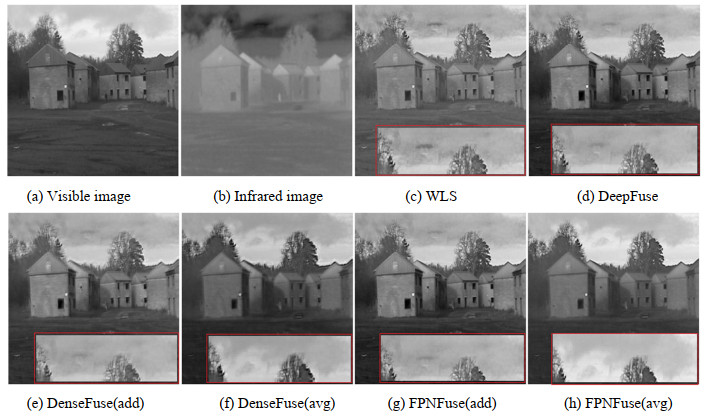

表 3 不同算法融合图像质量度量均值Table 3. The mean value of image quality evalution under different fusion algorithmsMethod EN SD MI Qab/f FMI_w VIF AT/s WLS 6.6861 34.4462 13.3723 0.5210 0.3630 0.6656 1.1688 DeepFuse add 6.8135 36.9112 13.6270 0.4536 0.4150 0.6908 0.2916 DenseFuse add 6.8558 35.6741 13.7116 0.3987 0.3567 0.6756 0.4611 avg 7.0173 42.5361 14.0346 0.4536 0.3651 0.8019 0.5237 Ours max 7.0327 43.3592 14.0655 0.5173 0.4338 0.7894 0.0298 avg 7.0672 44.5546 14.1345 0.5181 0.4394 0.8263 0.0248 nuclear 7.0576 44.6828 14.1152 0.5212 0.4374 0.8044 0.0335 选择一张有代表性的融合图像“房子”作为示例,FPNFuse与各图像融合框架所获得的融合图像如图 3所示。对于天空中的云朵,DeepFuse、WLS和使用加权平均的FPNFuse算法得到的融合图像均产生了很多伪影,其效果如图 3的红色矩形框所示。WLS、DeepFuse、DenseFuse(add)以及FPNFuse(add)的融合图像的云朵部分均产生了伪影。只有添加两阶段注意力模型的FPNFuse(avg)算法得到的融合图像的亮度与源可见光图像最相似,且云朵的形状未产生伪影与源图像最接近。房子前的人,只有添加了注意力模型的算法在融合时以红外图像为主,在光线不足的条件下融合图像更能够突出目标的轮廓。这些表现与客观评价结果一致,因此,本文提出的算法在主客观评价上均优于对比算法。

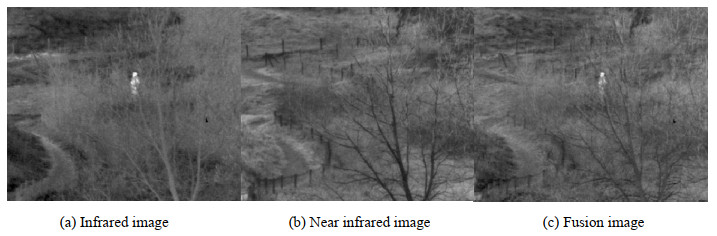

多尺度特征融合结合注意力模型同样适用于近红外与热红外图像等异源图像的融合,融合结果如图 4,该融合图像融合了两种图像的特征,保留很多细节部分且无伪影。

3. 结论

本文提出了一种基于多尺度和注意力模型的图像融合算法,通过对源图像多尺度特征的提取与融合,使得融合图像能够保留源图像的特征且不会产生伪影。在融合层加入了两阶段注意力模型,突出融合图像的轮廓。在公开数据集TNO上进行实验,从主观上可以看出,融合图像的亮度合理,细节纹理清晰,满足预期效果。客观评价指标表明,多数指标接近或优于对比算法,尤其是标准差、边缘保持度、视觉信息保真度和平均用时等指标较对比算法具有较大提升。实验结果表明基于对尺度和注意力模型能够有效融合可见光与红外图像。

-

表 1 编码网络和解码网络的设置

Table 1 The setting of encoder and decoder networks

Layer Size Stride Channel(input) Channel(output) Encoder C1 3 1 1 16 ECB10 - - 16 64 ECB20 - - 64 112 ECB30 - - 112 160 ECB40 - - 160 208 ECB50 - - 208 256 Decoder DCB41 - - 464 208 DCB31 - - 368 160 DCB21 - - 272 112 DCB11 - - 176 64 C2 1 1 64 1 ECB Conv 3 1 Nin 16 Conv 1 1 16 Nout max-pooling - - - - DCB conv 3 1 Nin 16 conv 1 1 16 Nout 表 2 不同融合策略下融合图像质量评价均值

Table 2 The mean value of image quality evalution under different fusion strategies

Method EN SD MI Qab/f FMI_w VIF DenseFuse add 6.8558 35.6741 13.7116 0.3987 0.3567 0.6756 ours 7.0173 42.5361 14.0346 0.4361 0.3651 0.8019 FPNFuse add 6.8312 36.6245 13.6625 0.463 0.4184 0.6818 ours 7.0672 44.5546 14.13447 0.5181 0.4394 0.8263 表 3 不同算法融合图像质量度量均值

Table 3 The mean value of image quality evalution under different fusion algorithms

Method EN SD MI Qab/f FMI_w VIF AT/s WLS 6.6861 34.4462 13.3723 0.5210 0.3630 0.6656 1.1688 DeepFuse add 6.8135 36.9112 13.6270 0.4536 0.4150 0.6908 0.2916 DenseFuse add 6.8558 35.6741 13.7116 0.3987 0.3567 0.6756 0.4611 avg 7.0173 42.5361 14.0346 0.4536 0.3651 0.8019 0.5237 Ours max 7.0327 43.3592 14.0655 0.5173 0.4338 0.7894 0.0298 avg 7.0672 44.5546 14.1345 0.5181 0.4394 0.8263 0.0248 nuclear 7.0576 44.6828 14.1152 0.5212 0.4374 0.8044 0.0335 -

[1] 赵立昌, 张宝辉, 吴杰, 等. 基于灰度能量差异性的红外与可见光图像融合[J]. 红外技术, 2020, 42(8): 775-782. https://www.cnki.com.cn/Article/CJFDTOTAL-HWJS202008012.htm ZHAO Lichang, ZHANG Baohui, WU Jie, et al. Fusion of infrared and visible images based on gray energy difference[J]. Infrared Technology, 2020, 42(8): 775-782. https://www.cnki.com.cn/Article/CJFDTOTAL-HWJS202008012.htm

[2] 白玉, 侯志强, 刘晓义, 等. 基于可见光图像和红外图像决策级融合的目标检测算法[J]. 空军工程大学学报(自然科学版), 2020, 21(6): 53-59, 100. DOI: 10.3969/j.issn.1009-3516.2020.06.009 BAI Yu, HOU Zhiqiang, LIU Xiaoyi, et al. An object detection algorithm based on decision-level fusion of visible light image and infrared image[J]. Journal of Air Force Engineering University(Natural Science Editon), 2020, 21(6): 53-59, 100. DOI: 10.3969/j.issn.1009-3516.2020.06.009

[3] 董安勇, 杜庆治, 苏斌, 等. 基于卷积神经网络的红外与可见光图像融合[J]. 红外技术, 2020, 42(7): 660-669. http://hwjs.nvir.cn/article/id/hwjs202007009 DONG Anyong, DU Qingzhi, SU Bin, et al. Infrared and visible image fusion based on convolutional neural network[J]. Infrared Technology, 2020, 42(7): 660-669. http://hwjs.nvir.cn/article/id/hwjs202007009

[4] 陈卓, 方明, 柴旭, 等. 红外与可见光图像融合的U-GAN模型[J]. 西北工业大学学报, 2020, 38(4): 904-912. DOI: 10.3969/j.issn.1000-2758.2020.04.027 CHEN Zhuo, FANG Ming, CHAI Xu, et al. Infrared and visible image fusion of U-GAN model[J]. Journal of Northwestern Polytechnical University, 2020, 38(4): 904-912. DOI: 10.3969/j.issn.1000-2758.2020.04.027

[5] 陈潮起, 孟祥超, 邵枫, 等. 一种基于多尺度低秩分解的红外与可见光图像融合方法[J]. 光学学报, 2020, 40(11): 72-80. https://www.cnki.com.cn/Article/CJFDTOTAL-GXXB202011008.htm CHEN Chaoqi, MENG Xiangchao, SHAO Feng, et al. Infrared and visible image fusion method based on multiscale low-rank decomposition [J]. Acta Optica Sinica, 2020, 40(11): 72-80. https://www.cnki.com.cn/Article/CJFDTOTAL-GXXB202011008.htm

[6] 林子慧. 基于多尺度变换的红外与可见光图像融合技术研究[D]. 成都: 中国科学院大学(中国科学院光电技术研究所), 2019. LIN Zihui. Research on Infrared and Visible Image Fusion Based on Multi-scale Trandform[D]. Chengdu: The Chinese Academy of Sciences(The Institute of Optics and Electronics), 2019.

[7] 马旗, 朱斌, 张宏伟. 基于VGG网络的双波段图像融合方法[J]. 激光与红外, 2019, 49(11): 1374-1380. DOI: 10.3969/j.issn.1001-5078.2019.11.018 MA Qi, ZHU Bin, ZHANG Hongwei. Dual-band image fusion method based on VGGNet[J]. Laser & Infrared, 2019, 49(11): 1374-1380. DOI: 10.3969/j.issn.1001-5078.2019.11.018

[8] LI H, WU X, Durrani T S. Infrared and visible image fusion with ResNet and zero-phase component analysis[J]. Infrared Physics & Technology, 2019, 102: 103039.

[9] LIN T, Dollár P, Girshick R, et al. Feature pyramid networks for object detection[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2017: 936-944.

[10] Woo S, Park J, Lee J, et al. CBAM: Convolution-al Block Attention Module[C]//ECCV, 2018: 3-19.

[11] LI H, WU X J, Durrani T. NestFuse: an infrared and visible image fusion architecture based on nest connection and spatial/channel attention models [J]. IEEE Transactions on Instrumentation and Measurement, 2020, 12(69): 9645-9656.

[12] 杨艳春, 李娇, 王阳萍. 图像融合质量评价方法研究综述[J]. 计算机科学与探索, 2018, 12(7): 1021-1035. https://www.cnki.com.cn/Article/CJFDTOTAL-KXTS201807002.htm YANG Yanchun, LI Jiao, WANG Yangping. Review of image fusion quality evaluation methods[J]. Journal of Frontiers of Computer Science and Technology, 2018, 12(7): 1021-1035. https://www.cnki.com.cn/Article/CJFDTOTAL-KXTS201807002.htm

[13] LIN T Y, Maire M, Belongie S, et al. Microsoft coco: common objects in context[C]//ECCV, 2014: 3-5.

[14] Toet A. TNO Image Fusion Dataset. figshare. Dataset[DB/OL]. https://doi.org/10.6084/m9.figshare.1008029.v2, 2014.

[15] LI H, WU X J. DenseFuse: a fusion approach to infrared and visible images[J]. IEEE Trans. Image Process, 2019, 28(5): 2614-2623.

[16] Prabhakar K R, Srikar V S, Babu R V. DeepFuse: a deep unsuper-vised approach for exposure fusion with extreme exposure image pairs[C]//2017 IEEE International Conference on Computer Vision (ICCV), 2017: 4724-4732.

[17] MA J, ZHOU Z, WANG B. et al. Infrared and visible image fusion based on visual saliency map and weighted least square optimization[J]. Infrared Physics & Technology, 2017, 82: 8-17.

-

期刊类型引用(4)

1. 种法亭,董张玉,杨学志,曾庆旺. 基于双通道多尺度特征提取和注意力的SAR与多光谱图像融合. 红外技术. 2024(01): 61-73 .  本站查看

本站查看

2. 朱其然,樊然然. 基于深度卷积网络的多聚焦图像自动融合方法. 信息与电脑(理论版). 2024(02): 122-124 .  百度学术

百度学术

3. 鲁晓涵,李洋,贾耀东,邰昱博,徐宇. 基于GAN改进的红外光与可见光图像融合算法研究. 电光与控制. 2024(06): 42-46+73 .  百度学术

百度学术

4. 李秋恒,邓豪,刘桂华,庞忠祥,唐雪,赵俊琴,卢梦圆. 基于多尺度及多头注意力的红外与可见光图像融合. 红外技术. 2024(07): 765-774 .  本站查看

本站查看

其他类型引用(5)

下载:

下载: