Infrared and Visible-Light Image Fusion Based on FCM and Guided Filtering

-

摘要: 针对传统红外与可见光图像融合算法中存在的目标模糊、细节丢失、算法不稳定等问题,提出了一种基于模糊C均值聚类(Fuzzy C-means, FCM)与引导滤波的红外与可见光图像融合方法。原图像经过非下采样剪切波变换(Nonsubsampled Shearlet Transform, NSST)后对低频子带进行引导滤波增强,再利用FCM与双通道脉冲发放皮层模型(Dual Channel Spiking Cortical Model, DCSCM)结合对高低频子带进行融合,最后经NSST逆变换得到融合图像。实验结果表明,本文算法稳定,主观评价上所得融合图像目标明确,细节保留较为完整,客观评价上在标准差、互信息、平均梯度、信息熵和边缘保留因子等评价标准中表现优良。

-

关键词:

- 图像处理 /

- 模糊C均值聚类 /

- 引导滤波 /

- 双通道脉冲发放皮层模型

Abstract: To solve the problems of vague targets, detail loss, and algorithm instability in traditional infrared and visible-light image fusion algorithms, a fusion method based on fuzzy c-means (FCM) clustering and guided filtering is proposed. The low-frequency sub-band was enhanced by guided filtering after applying a non-subsampled shearlet transform (NSST) to the original image. The low- and high-frequency sub-bands were then fused using FCM clustering and a dual-channel spiking cortical model. Finally, the fused image was obtained using an inverse NSST transform. The experimental results showed that the proposed algorithm was stable, the fusion image had clear targets and relatively complete details in the subjective evaluation, and the algorithm had an excellent standard deviation, mutual information, average gradient, information entropy, and edge retention factor in the objective evaluation. -

0. 引言

图像融合将同一场景下包含不同信息的多幅图像融合成一张图像,增加图像的信息量和利用率[1]。红外光与可见光图像融合是图像融合领域一个重要的研究方向。红外图像具有热辐射信息,可利用其查找目标,但红外图像的分辨率较低。可见光图像具有较为清晰的背景信息,符合人的视觉特性,但可见光传感器容易受到天气的影响。因此,可采用红外与可见光图像的融合图像,对两者优势进行互补,从而得到特征明显、目标突出、细节丰富和高对比度清晰的图像,可广泛应用于军事侦察、目标检测和识别等领域[2]。

目前,变换域中的图像融合大都采用多尺度多方向变换方法[3]。常用的多尺度分解方法包括小波变换(Wavelet Transform, WT),Contourlet变换、非下采样Contourlet变换(Nonsubsampled Contourlet Transform, NSCT)[4]和非下采样剪切波变换(Nonsubsampled Shearlet Transform, NSST)[5]。Zhao等[6]提出了Contourlet变换方法,但因为需要下采样操作使其不具有平移不变性,导致有伪吉布斯效应出现。任亚飞等[7]提出了具有平移不变性和方向选择性等优良特性的NSST变换方法,克服了伪吉布斯效应,得到了较好的融合图像。参数自适应脉冲耦合神经网络(Parameter-adaptive Pulse Coupled Neural Network, PA-PCNN)是一种融合方法,Zhou等[8]应用其得到了具有丰富细节的融合图像。李文等[9]应用了双通道脉冲发放皮层模型(Dual Channel Spiking Cortical Model, DCSCM),使得图像融合的效率更高。但单纯NSST与DCSCM的结合并不能保证目标信息的完整提取和图像纹理细节完整的保留。

模糊C均值聚类(Fuzzy C-means, FCM)是一种非监督的模式识别方法,利用样本的隶属度实现数据的分类。由于红外图像存在图像边界模糊、对比度低等缺陷,模糊C均值聚类法相比于其他图像分割法对红外图像的处理具有一定优势[10]。引导滤波与传统滤波器相比,其优势在于能够在平滑图像、保留图像整体的同时,还能保持图像边缘梯度、增强图像纹理细节信息[11]。

本文提出了一种基于FCM与引导滤波,结合NSST和DCSCM的红外光与可见光图像融合算法,既能解决NSST域的空间扭曲问题,又能更完整地提取目标信息、更多地保留图像纹理细节,最终得到目标明确、纹理细节丰富的融合图像。

1. 基本原理

1.1 模糊C-均值聚类(FCM)

模糊C-均值聚类是经典的模糊聚类算法[12],是将各数据到所属类的中心的欧氏距离的最小值作为目标函数来实现对数据的分类方法。具体步骤如下:

设一个数据样本X={x1, x2, …, xn},如果要通过FCM将其内的数据划分为c类,则可以采用求解一个数学规划的方法来实现。

其中,数学规划的目标函数为:

$$ \min {\text{ }}{J_{{\text{FCM}}}}(U,V) = \sum\limits_{i = 1}^c {\sum\limits_{j = 1}^n {{{({u_{ij}})}^m}{d^2}({x_j},{v_i})} } $$ (1) 上述目标函数中各个变量满足条件:

$$ \left\{ \begin{gathered} \sum\limits_{i = 1}^c {{u_{ij}}} = 1,1 \leqslant j \leqslant n \hfill \\ {u_{ij}} \geqslant 0,1 \leqslant i \leqslant c,1 \leqslant j \leqslant n \hfill \\ \end{gathered} \right. $$ (2) 在上述的数学规划中,U={uij}是一个大小为c×n的矩阵,矩阵中的每个元素可以理解为数据xj隶属于第i个类的程度;V={vi}(i=1, 2, …, c)为每一类样本的中心;d(xj, vi)则为数据xj到每一类样本的中心vi的欧氏距离,其具体计算公式如式(3)所示:

$$ d({x_j},{v_i}) = \left\| {{x_j} - {v_i}} \right\| $$ (3) 上述已将FCM转化为一个数学规划问题,根据拉格朗日乘数法来求解极值。首先,通过待定系数λj将约束条件与目标函数进行联立从而得出一个新函数:

$$ L({u_{ij}},{v_i},\lambda ) = \sum\limits_{i = 1}^c {\sum\limits_{j = 1}^n {{{({u_{ij}})}^m}{d^2}({x_j},{v_i})} } + \sum\limits_{j = 1}^n {{\lambda _j}(1 - \sum\limits_{i = 1}^c {{u_{ij}}} )} $$ (4) 式中:m为加权指数,一般取大于1的实数。

再由以下方程组得到uij、vi、λj的偏导数,即:

$$ \left\{ \begin{gathered} \frac{{\partial L}}{{\partial {u_{ij}}}} = 0 \hfill \\ \frac{{\partial L}}{{\partial {v_i}}} = 0 \hfill \\ \frac{{\partial L}}{{\partial {\lambda _j}}} = 0 \hfill \\ \end{gathered} \right. $$ (5) 联立式(2)以及式(5)可得:

$$ {v_i} = \frac{{\sum\limits_{j = 1}^n {u_{ij}^m{x_j}} }}{{\sum\limits_{j = 1}^n {u_{ij}^m} }} $$ (6) $$ {u_{ij}} = \frac{1}{{\sum\limits_{r = 1}^c {[{{(\frac{{d({x_j},{v_i})}}{{d({x_j},{v_r})}})}^{\frac{2}{{m - 1}}}}]} }} $$ (7) 式中:uijm为加权指数为m的(i, j)位置处的隶属度;vr是子集r的样本中心;r是变量,属于集合c。

接下来根据式(7)计算出在下一次迭代次数下每一类的中心vij(k+1)的值:

$$ v_{ij}^{(k + 1)} = \frac{{\sum\limits_{j = 1}^n {{{(u_{ij}^k)}^m}{x_j}} }}{{\sum\limits_{j = 1}^n {{{(u_{ij}^k)}^m}} }} $$ (8) 式中:vijk为加权指数为k的(i, j)位置处的隶属度。

最后,判断是否达到结束的条件,即是否满足||Vk+1-Vk||<ε或者k>T。如果满足,则停止迭代,当前迭代次数下的U和V则为所求的结果,根据U中的每个元素的大小来将每一个数据分到最佳的类中。否则继续迭代。

1.2 引导滤波

引导滤波是一种基于局部线性模型的边缘保持算法[13]。在引导滤波算法中,规定引导图像为I,输入图像为P,输出图像为Q,则I与Q之间有线性关系:

$$ {Q_\tau } = {a_d}{I_\tau } + {b_d}{\text{, }}\forall \tau \in {\omega _d} $$ (9) 式中:τ为像素索引;ad,bd为线性系数。转化为最优化的问题:

$$ E({a_d},{b_d}) = \sum\limits_{i \in {{\bf{ \pmb{\mathsf{ ω}} }}_d}} {({{({a_d}{I_\tau } + {b_d} - {P_\tau })}^2} + {\varepsilon _{\text{1}}}{a_d}^2)} $$ (10) 式中:ωd为以向导图I中一点d为中心,大小为(2r+1)×(2r+1)的局部窗。ε1为归一化因子。可使用线性回归求解公式的解:

$$ {a_d} = \frac{{\frac{1}{{\left| \omega \right|}}\sum\limits_{\tau \in {{\bf{ \pmb{\mathsf{ ω}} }}_d}} {{I_\tau }{P_\tau } - {\mu _d}\overline {{P_d}} } }}{{\sigma _d^2 + {\varepsilon _1}}} $$ (11) $$ {b_d} = {\overline P _d} - {a_d}{\mu _d} $$ (12) 式中:μd为向导图I的均值;σd2表示I的方差;$ \overline {{P_d}} $表示P在窗口ωd中的均值;|ω|表示窗口内的像素数。

1.3 双通道脉冲发放皮层模型(DCSCM)

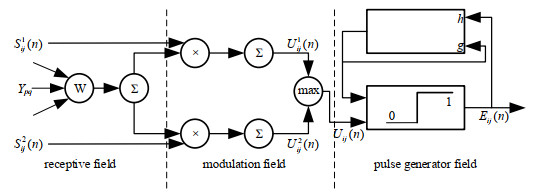

DCSCM[14]比SCM(Spiking Cortical Model)模型对较暗区域的信息提取度更高,对细节信息捕捉能力更好。

DCSCM原理框图如图 1所示。首先外部激励和进入DCSCM神经元中的接收区,经过调制区调制后,获得神经元的内部活动项,取其最大值为uij(n),如果uij(n)大于阈值Eij(n),则神经元在脉冲产生区点火。x和y分别为Eij(n)的衰减和放大系数。

DCSCM模型的数学表达式如公式(13)所示:

$$\left\{ {\begin{array}{*{20}{l}} {{L_{ij}}(n) = {V_l}\sum\limits_{kl} {{W_{ijkl}}} {Y_{kl}}(n - 1)}\\ {U_{ij}^1(n) = S_{ij}^1\sum\limits_{kl} {{W_{ijkl}}} {Y_{kl}}(n - 1) + S_{ij}^1}\\ {U_{ij}^2(n) = S_{ij}^2\sum\limits_{kl} {{W_{ijkl}}} {Y_{kl}}(n - 1) + S_{ij}^2}\\ {{U_{ij}}(n) = \max \left\{ {U_{ij}^1(n),U_{ij}^2(n)} \right\}}\\ {{E_{ij}}(n) = g{E_{ij}}(n - 1) + h{Y_{ij}}(n - 1) - \mathit{\Delta} }\\ {{Y_{ij}}(n) = \left\{ {\begin{array}{*{20}{l}} {1,{\rm{ if }}{U_{ij}}(n) > {E_{ij}}(n)}\\ {0,{\rm{ otherwise }}} \end{array}} \right.} \end{array}} \right.$$ (13) 式中:(i, j)为像素点;n为迭代次数;W为连接权重;Δ是一个正常数,控制动态门限的下降幅度;Vl为增益幅度;Ykl为邻域神经元的输出;uij1(n)和uij2(n)是神经元的内部行为;Yij(n)为DCSCM的脉冲输出。当Yij(n)=1时,表示神经元一次点火。

2. 本文融合方法

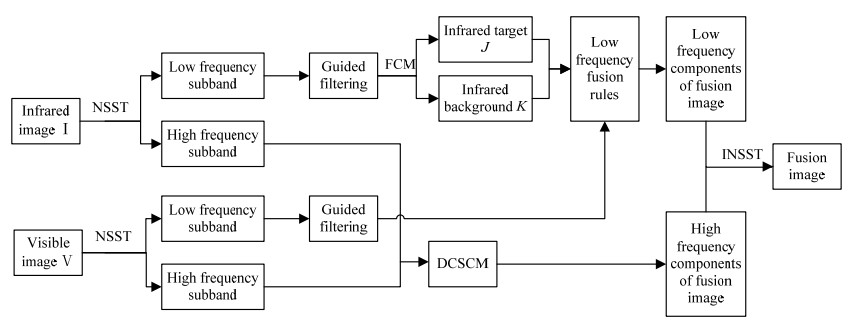

图 2为本文融合方法。首先,使用NSST将源红外图像I与源可见光图像V分别分解得到高低频子带。然后,在低频融合过程中,通过基于引导滤波结合FCM的方法得到低频融合系数;在高频融合中,使用DCSCM的方法得到高频融合系数。最后,对高低频融合系数进行NSST逆变换得到融合图像。

2.1 基于FCM结合引导滤波低频融合规则

低频信息中携带着图像的大部分能量,可见光图像的低频子带,包含了绝大部分的背景纹理信息,而红外图像的目标边缘信息也很重要。故而先对可见光图像和红外图像的低频子带进行引导滤波,不仅能还原变换过程中的背景纹理信息,还能保护红外目标的边缘信息。

为了更为完整地提取红外图像的目标信息,接下来采用FCM提取源红外图像的目标区域J,并将J内的系数直接作为低频融合系数。将分割出的背景区域K与可见光低频子带采用比较信息熵大小的方法进行融合系数选取。

设经过引导滤波的红外低频子带为I1,经引导滤波的可见光低频子带为V1。具体的规则如下:

1)将I1中点的灰度值作为数据集,利用FCM算法进行聚类,设聚类数为2,将聚类结果系数较大的一类记为M1。

2)计算源红外图像I1中每个子带系数所在邻域的空间频率S(i, j)。

$$ \begin{gathered} S(i,j) = \frac{1}{9}\sum\limits_{m = i - 1}^{i + 1} {\sum\limits_{n = j - 1}^{j + 1} {({{({I_1}(i,j + 1) - {I_1}(i,j))}^2}} } \hfill \\ \quad \quad \quad \;\; + {({I_1}(i + 1,j) - {I_1}(i,j))^2}) \hfill \\ \end{gathered} $$ (14) 3)以S(i, j)中的各个元素的集合作为样本数据集,再使用FCM进行聚类,设置聚类数为2,聚类完成后,将其中空间频率较大的子带系数用M2表示。

4)对于源红外图像I1中的系数,如果其满足I1(i, j)∈{M1∩M2},则将其作为低频融合系数的目标区域系数。即:

$$ {F_{{\text{ol}}}}(i,j) = {I_1}(i,j){\text{ }},{\text{ }}{I_1}(i,j) \in \{ {M_1} \cap {M_2}\} $$ (15) 式中:Fol(i, j)是目标区域低频系数。对于背景区域的低频系数Fbl(i, j)有:

$$F_{\mathrm{bl}}(i, j)= \begin{cases}V_1(i, j), & \mathrm{EN}_V \geq \mathrm{EN}_I \text { or } V_1(x, y) \geq I_1(x, y) \\ I_1(i, j), & \text { else }\end{cases}$$ (16) 其中,信息熵EN的表达式为:

$$ {\text{EN}} = - \sum\limits_{i = 0}^{255} {{p_m}{{\log }_2}{p_m}} $$ (17) 式中:pm为图像第m级灰度值出现的概率。

最终得到的低频融合系数F(i, j)为:

$$ F(i,j) = \left\{ \begin{gathered} {F_{{\text{ol}}}}(i,j),{\text{ }}(i,j) \in J \hfill \\ {F_{{\text{bl}}}}(i,j),{\text{ }}(i,j) \in K \hfill \\ \end{gathered} \right. $$ (18) 2.2 基于DCSCM的高频融合规则

高频分量主要携带源图像中的细节信息,本文使用更加符合人眼特性的DCSCM模型对高频子带进行融合,并将能测量图像清晰度和边缘突出程度的区域能量E与改进拉普拉斯能量和SML[15]作为DCSCM的外部激励,继而获得高频子带图像的融合系数Fh(i, j)。

区域能量:

$$ E(i,j) = \sum\limits_{m = - (M - 1)/2}^{(M - 1)/2} {\sum\limits_{n = - (N - 1)/2}^{(N - 1)/2} {{{({I_{\text{h}}}(i + m,j + n))}^2}} } $$ (19) 改进拉普拉斯能量和SML:

$$ {\text{SM}}{{\text{L}}_{{\text{Ih}}}}(i,j) = \sum\limits_{r = - (M - 1)/2}^{(M - 1)/2} {\sum\limits_{c = - (N - 1)/2}^{(N - 1)/2} {{\text{M}}{{\text{L}}_{{\text{Ih}}}}(i + r,j + c)} } $$ (20) M和N为常数,MLlh定义为:

$$ \begin{gathered} {\text{M}}{{\text{L}}_{{\text{Ih}}}}(i,j) = \left| {2{I_{\text{h}}}(i,j) - {I_{\text{h}}}(i + 1,j) - {I_{\text{h}}}(i - 1,j)} \right| \hfill \\ {\text{ }} + \left| {2{I_{\text{h}}}(i,j) - {I_{\text{h}}}(i,j + 1) - {I_{\text{h}}}(i,j - 1)} \right| \hfill \\ \end{gathered} $$ (21) 然后,将E与SML的乘积作为DCSCM的外部激励:

$$ S(i,j) = {E_{{\text{Ih}}}}(i,j){\text{SM}}{{\text{L}}_{{\text{Ih}}}}(i,j) $$ (22) 最终选取信息熵大的系数作为高频融合系数:

$$ {F_{\text{h}}}(i,j) = \left\{ \begin{gathered} {V_{\text{h}}}(i,j),\quad {\text{E}}{{\text{N}}_V} \geqslant {\text{E}}{{\text{N}}_I} \hfill \\ {R_{\text{h}}}(i,j),\quad {\text{E}}{{\text{N}}_V} < E{N_I} \hfill \\ \end{gathered} \right. $$ (23) 3. 实验结果与分析

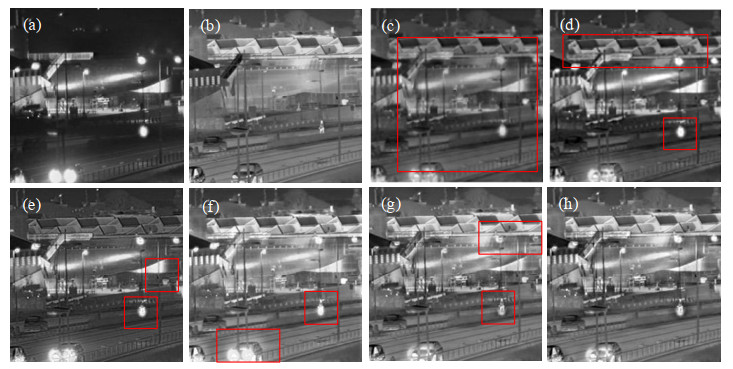

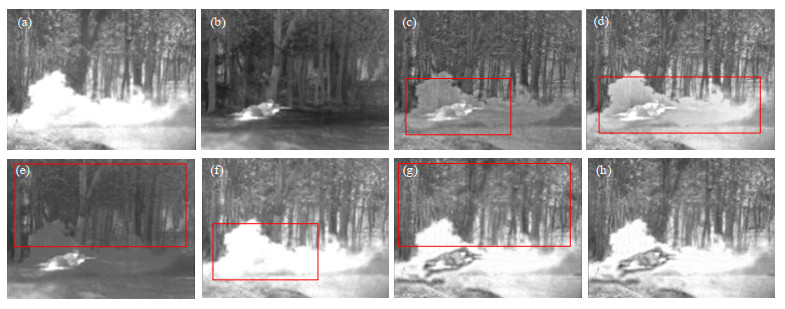

实验选择TNO数据集中3组图片进行,并与MGFF[16]、MSD[17]、MTD[18]、VIP[19]、FCMA[20]等方法进行了验证比较。本文设定NSST层数为4,分解方向数为[4,4,16,16],使用“maxflat”滤波器。

3.1 主观评价

如图 3所示,图(c)的对比度较低,背景信息与红外目标难以分辨。图(d)的对比度较图(c)高,但红外目标难以分辨,且背景信息有丢失。图(e)融合了红外目标,但图像对比度较低,不能很好地分辨背景信息和红外目标信息。图(f)的对比度较图(e)更加高,但红框内的融合效果较差。图(g)背景信息丰富,目标明确,但与图(h)相比,图(g)的对比度较低,红框内的细节信息略有丢失。本文算法所得融合图像,具有目标突出、对比度适中和细节信息保留较为完整等特点。

如图 4所示,图(c)的对比度较低,红外目标不清晰,背景信息暗。图(d)的对比度较图(c)高,但红外目标仍不突出。图(e)的对比度低,目标信息不明显。图(f)的目标信息较图(e)更为突出,但树木的细节模糊。图(g)中的目标明确,树木纹理较为清晰,但与图(h)相比,图(g)的对比度较低,右上角热源不明显,且红框内树木周围有伪影。本文算法所得融合图像,对比度较高,凸显了显著性目标与右上角热源信息,而且具有更多的细节信息,并抑制了伪影的出现。

如图 5所示,图(c)的对比度较低,背景信息丢失严重。图(d)的对比度较图(c)高,但红外目标信息略有丢失。图(e)的目标人物较为明确,但图像对比度低,背景信息缺失严重。图(f)几乎只保留了可见光图像的信息,看不到红外目标信息。图(g)中目标信息较为明确,融合效果良好,但与图(h)相比,图(g)的背景信息保留较差。本文算法所得的融合图像,具有目标明确、背景信息丰富等特点,且算法稳定,对比其他算法有明显优势。

为了得到更加全面的评价,本文使用主观评价的5分制为主观评价尺度评分表,如表 1所示。在专业人员进行评价时使用妨碍尺度,在非专业人员评价时使用质量尺度。

表 1 主观评价尺度评分Table 1. Subjective evaluation scale score tableScore Quality scale Obstruction scale 5 very nice Lossless image quality 4 nice The image quality is damaged, but it does not hinder viewing 3 normal Clearly see that the image quality is damaged 2 poor Obstruction to viewing 1 very poor Serious impact on viewing 3名专业人员,2名非专业人员对照表 1对本文方法得到的3组图像进行评价,对评价分数取平均分得到最终的主观评价结果,如表 2所示。

表 2 五分制评价结果Table 2. Five point evaluation resultsFirst set of image scores Second set of image scores Third set of image scores Professional person 1 4 5 4 Professional person 2 5 5 4 Professional person 3 4 4 4 Nonprofessional person 1 5 5 5 Nonprofessional person 2 5 5 4 Average score 4.6 4.8 4.2 由五分制评价结果的平均分得出本文方法得到的三组融合图像在质量尺度上评价为“nice”,在妨碍尺度上为“The image quality is damaged, but it does not hinder viewing”。

3.2 客观评价

本文选用标准差(Standard Deviation, STD)、互信息(Mutual Information, MI)、平均梯度(Average Gradient, AG)、信息熵(Entropy, EN)、边缘保留因子(QAB/F)和结构相似度(Structural Similarity, SSIM)作为客观评价标准,结果如表 3所示。

表 3 客观评价指标Table 3. Objective evaluation resultsImage Algorithm STD MI AG EN QAB/F SSIM Group 1 MGFF 48.5438 2.5642 10.7398 7.3355 0.5691 0.5038 MSD 48.3475 2.5589 11.2680 7.2762 0.5925 0.4877 MTD 43.3842 3.0839 9.8755 6.9701 0.5456 0.4722 VIP 44.8607 0.5109 10.4776 7.2307 0.5665 0.6142 FCMA 43.9961 3.1582 10.5662 7.3527 0.6230 0.4964 Proposed 45.0086 3.1720 10.7624 7.3768 0.5978 0.5090 Group 2 MGFF 36.6809 1.7426 4.9351 6.8599 0.4702 0.5268 MSD 52.3717 2.5234 4.7900 7.0811 0.4706 0.4854 MTD 52.1024 3.0416 4.3414 6.8654 0.4563 0.4920 VIP 52.8195 0.3818 4.3009 6.9521 0.5332 0.7334 FCMA 60.5238 3.1647 4.6397 7.3857 0.4877 0.4375 Proposed 60.1718 3.2102 4.6594 7.4388 0.4564 0.4693 Group 3 MGFF 40.0211 1.5924 6.7958 7.2387 0.4799 0.5095 MSD 49.7948 2.3439 6.8837 7.2386 0.5371 0.4871 MTD 60.7380 4.4287 6.3965 7.1101 0.5810 0.4641 VIP 56.0103 0.6042 5.6657 6.7389 0.5663 0.6618 FCMA 57.0775 2.3680 6.1483 7.2681 0.4667 0.4515 Proposed 57.4021 3.0526 6.6048 7.2777 0.5556 0.4753 从表 3可以看到:本文算法在第一组图像中,MI、AG、EN三个指标都优于其他算法;第二组图像MI、EN有优势,STD为次高;第三组图像鉴于主观结果不与VIP方法作比较,可以看出本文算法有4个指标高于MGFF方法、MSD方法和VIP方法,3个指标高于文献[18]的MTD方法,6个指标都高于文献[20]的FCMA方法。可以看出本文在标准差、互信息、平均梯度、信息熵和边缘保留因子这5个指标上表现良好。本文使用了引导滤波,因此可从主观效果和边缘保留因子看出本文算法较FCMA方法细节保留能力更强,结构相似度得到了提升。综合来看本文算法较有优势。

4. 结论

提出了一种基于FCM与引导滤波的红外与可见光图像融合算法,利用FCM的非监督和聚类效果好等优势,结合引导滤波保留细节能力强与DCSCM融合效果优良等特点,对可见光与红外图像进行融合。采用了主观和客观两种方法对本文算法做出评价,证明了本文算法的有效性。但本文算法的结构相似度较低,是以后可进一步研究的一个方向。

-

表 1 主观评价尺度评分

Table 1 Subjective evaluation scale score table

Score Quality scale Obstruction scale 5 very nice Lossless image quality 4 nice The image quality is damaged, but it does not hinder viewing 3 normal Clearly see that the image quality is damaged 2 poor Obstruction to viewing 1 very poor Serious impact on viewing 表 2 五分制评价结果

Table 2 Five point evaluation results

First set of image scores Second set of image scores Third set of image scores Professional person 1 4 5 4 Professional person 2 5 5 4 Professional person 3 4 4 4 Nonprofessional person 1 5 5 5 Nonprofessional person 2 5 5 4 Average score 4.6 4.8 4.2 表 3 客观评价指标

Table 3 Objective evaluation results

Image Algorithm STD MI AG EN QAB/F SSIM Group 1 MGFF 48.5438 2.5642 10.7398 7.3355 0.5691 0.5038 MSD 48.3475 2.5589 11.2680 7.2762 0.5925 0.4877 MTD 43.3842 3.0839 9.8755 6.9701 0.5456 0.4722 VIP 44.8607 0.5109 10.4776 7.2307 0.5665 0.6142 FCMA 43.9961 3.1582 10.5662 7.3527 0.6230 0.4964 Proposed 45.0086 3.1720 10.7624 7.3768 0.5978 0.5090 Group 2 MGFF 36.6809 1.7426 4.9351 6.8599 0.4702 0.5268 MSD 52.3717 2.5234 4.7900 7.0811 0.4706 0.4854 MTD 52.1024 3.0416 4.3414 6.8654 0.4563 0.4920 VIP 52.8195 0.3818 4.3009 6.9521 0.5332 0.7334 FCMA 60.5238 3.1647 4.6397 7.3857 0.4877 0.4375 Proposed 60.1718 3.2102 4.6594 7.4388 0.4564 0.4693 Group 3 MGFF 40.0211 1.5924 6.7958 7.2387 0.4799 0.5095 MSD 49.7948 2.3439 6.8837 7.2386 0.5371 0.4871 MTD 60.7380 4.4287 6.3965 7.1101 0.5810 0.4641 VIP 56.0103 0.6042 5.6657 6.7389 0.5663 0.6618 FCMA 57.0775 2.3680 6.1483 7.2681 0.4667 0.4515 Proposed 57.4021 3.0526 6.6048 7.2777 0.5556 0.4753 -

[1] LI Shutao, KANG Xudong, FANG Leyuan, et al. Pixel-level image fusion: a survey of the state of the art[J]. Information Fusion, 2017, 33(1): 100-112

[2] 蔡李美, 李新福, 田学东. 基于分层图像融合的虚拟视点绘制算法[J]. 计算机工程, 2021, 47(4): 204-210. DOI: 10.19678/j.issn.1000-3428.0058057. CAI L M, LI X F, TIAN X D. Virtual viewpoint rendering algorithm based on hierarchical image fusio [J]. Computer Engineering, 2021, 47(4): 204-210. DOI: 10.19678/j.issn.1000-3428.0058057

[3] 冯鑫, 张建华, 胡开群, 等. 基于变分多尺度的红外与可见光图像融合[J]. 电子学报, 2018, 46(3): 680-687. https://www.cnki.com.cn/Article/CJFDTOTAL-DZXU201803025.htm FENG X, ZHANG J H, HU K Q, et al. The infrared and visible image fusion method based on variational multiscale[J]. Acta Electronica Sinica, 2018, 46(3): 680-687. https://www.cnki.com.cn/Article/CJFDTOTAL-DZXU201803025.htm

[4] LIU Y, LIU S, WANG Z. A general framework for image fusion based on multi-scale transform and sparse representation[J]. Information Fusion, 2015, 24: 147-164. DOI: 10.1016/j.inffus.2014.09.004

[5] 李威, 李忠民. NSST域红外和可见光图像感知融合[J]. 激光与光电子学进展, 2021, 58(20): 202-210. https://www.cnki.com.cn/Article/CJFDTOTAL-JGDJ202120021.htm LI W, LI Z M. NSST-Based perception fusion method for infrared and visible images[J]. Laser & Optoelectronics Progress, 2021, 58(20): 202-210. https://www.cnki.com.cn/Article/CJFDTOTAL-JGDJ202120021.htm

[6] ZHAO W D, LU H C. Medical image fusion and denoising with altering sequential filter and adaptive fractional order total variation[J]. IEEE Transactions on Instrumentation and Measurement, 2017, 66(9) : 2283-2294 DOI: 10.1109/TIM.2017.2700198

[7] 任亚飞, 张娟梅. 基于NSST多尺度熵的红外与可见光图像融合[J]. 兵器装备工程学报, 2022, 43(7): 278-285. https://www.cnki.com.cn/Article/CJFDTOTAL-CUXI202207042.htm REN Y F, ZHANG J M. Infrared and visible image fusion based on NSST multi-scale entropy[J]. Journal of Ordnance Equipment Engineering, 2022, 43(7): 278-285. https://www.cnki.com.cn/Article/CJFDTOTAL-CUXI202207042.htm

[8] ZHOU Z Q, WANG B, LI S, et al. Perceptual fusion of infrared and visible images through a hybrid multiscale decomposition with Gaussian and bilateral filters[J]. Information Fusion, 2016, 30(30): 15-26.

[9] 李文, 叶坤涛, 舒蕾蕾, 等. 基于高斯模糊逻辑和ADCSCM的红外与可见光图像融合算法[J]. 红外技术, 2022, 44(7): 693-701. http://hwjs.nvir.cn/article/id/227ae3cd-57b4-4ec7-a248-bdc1de60993c LI W, YE K T, SHU L L, et al. Infrared and visible image fusion algorithm based on gaussian fuzzy logic and adaptive dual-channel spiking cortical model[J]. Infrared Technology, 2022, 44(7): 693-701. http://hwjs.nvir.cn/article/id/227ae3cd-57b4-4ec7-a248-bdc1de60993c

[10] 张莲, 杨森淋, 禹红良, 等. 改进非局部核模糊C-均值聚类的红外图像分割[J]. 重庆理工大学学报: 自然科学, 2020, 34(11): 130-137. https://www.cnki.com.cn/Article/CJFDTOTAL-CGGL202011018.htm ZHANG L, YANG S L, YU H L, et al. Improved infrared image segmentation based on nonlocal nuclear fuzzy C-means clustering[J]. Journal of Chongqing University of Technology: Natural Science, 2020, 34(11): 130-137. https://www.cnki.com.cn/Article/CJFDTOTAL-CGGL202011018.htm

[11] 赵程, 黄永东. 基于滚动导向滤波和混合多尺度分解的红外与可见光图像融合方法[J]. 激光与光电子学进展, 2019, 56(14): 106-120. https://www.cnki.com.cn/Article/CJFDTOTAL-JGDJ201914013.htm ZHAO C, HUANG Y D. Infrared and visible image fusion via rolling guidance filtering and hybrid multi-sacle decomposition[J]. Laser & Optoelectronics Progress, 2019, 56(14): 106-120. https://www.cnki.com.cn/Article/CJFDTOTAL-JGDJ201914013.htm

[12] 李旭超, 刘海宽, 王飞, 等. 图像分割中的模糊聚类方法[J]. 中国图象图形学报, 2012, 17(4): 447-458. https://www.cnki.com.cn/Article/CJFDTOTAL-ZGTB201204004.htm LI X C, LIU H K, WANG F, et al. The survey of fuzzy clustering method for image segmentation[J]. Journal of Image and Graphics, 2012, 17(4): 447-458. https://www.cnki.com.cn/Article/CJFDTOTAL-ZGTB201204004.htm

[13] 谢伟, 周玉钦, 游敏. 融合梯度信息的改进引导滤波[J]. 中国图象图形学报, 2016, 21(9): 1119-1126. https://www.cnki.com.cn/Article/CJFDTOTAL-ZGTB201609001.htm XIE W, ZHOU Y, YOU M. Improved guided image filtering integrated with gradient information[J]. Journal of Image and Graphics, 2016, 21(9): 1119-1126. https://www.cnki.com.cn/Article/CJFDTOTAL-ZGTB201609001.htm

[14] 江泽涛, 吴辉, 周哓玲. 基于改进引导滤波和双通道脉冲发放皮层模型的红外与可见光图像融合算法[J]. 光学学报, 2018, 38(2): 0210002. https://www.cnki.com.cn/Article/CJFDTOTAL-GXXB201802015.htm JIANG Z T, WU H, ZHOU X L. Infrared and visible image fusion algorithm based on improved guided filtering and dual-channel spiking cortical model[J]. Acta Optica Sinica, 2018, 38(2): 0210002. https://www.cnki.com.cn/Article/CJFDTOTAL-GXXB201802015.htm

[15] HUANG W, JING Z L. Evaluation of focus measures in multi-foucus image fusion[J]. Pattern Recognition Letters, 2007, 28(4): 493-500

[16] Bavirisetti D P, XIAO G, ZHAO J, et al. Multi-scale guided image and video fusion: a fast and efficient approach[J]. Circuits Syst Signal Process, 2019, 38: 5576–5605.

[17] ZHOU Z Q, WANG B, LI S, et al. Perceptual fusion of infrared and visible images through a hybrid multi-scale decomposition with Gaussian and bilateral filters[J]. Information Fusion, 2016, 30: 16-25.

[18] CHEN J, LI X J, LUO L B, et al. Infrared and visible image fusion based on target-enhanced multiscale transform decomposition[J]. Information Sciences, 2020, 508: 64-78.

[19] ZHANG Y, ZHANG L J, BAI X Z, et al. Infrared and visual image fusion through infrared feature extraction and visual information preservation[J]. Infrared Physics and Technology, 2017, 83: 227-237.

[20] 巩稼民, 刘爱萍, 张晨, 等. 基于FCM与ADSCM的红外与可见光图像融合[J]. 激光与光电子学进展, 2020, 57(20): 222-230. https://www.cnki.com.cn/Article/CJFDTOTAL-JGDJ202020025.htm GONG J M, LIU A P, ZHANG C, et al. Infrared and visible light image fusion based on FCM and ADSCM[J]. Laser & Optoelectronics Progress, 2020, 57(20): 222-230. https://www.cnki.com.cn/Article/CJFDTOTAL-JGDJ202020025.htm

-

期刊类型引用(2)

1. 杨艳春,雷慧云,杨万轩. 基于快速联合双边滤波器和改进PCNN的红外与可见光图像融合. 红外技术. 2024(08): 892-901 .  本站查看

本站查看

2. 祁艳杰,侯钦河. 多尺度和卷积注意力相结合的红外与可见光图像融合. 红外技术. 2024(09): 1060-1069 .  本站查看

本站查看

其他类型引用(0)

下载:

下载: